Maschinenbau-

Wiki

Begriffe leicht erklärt.

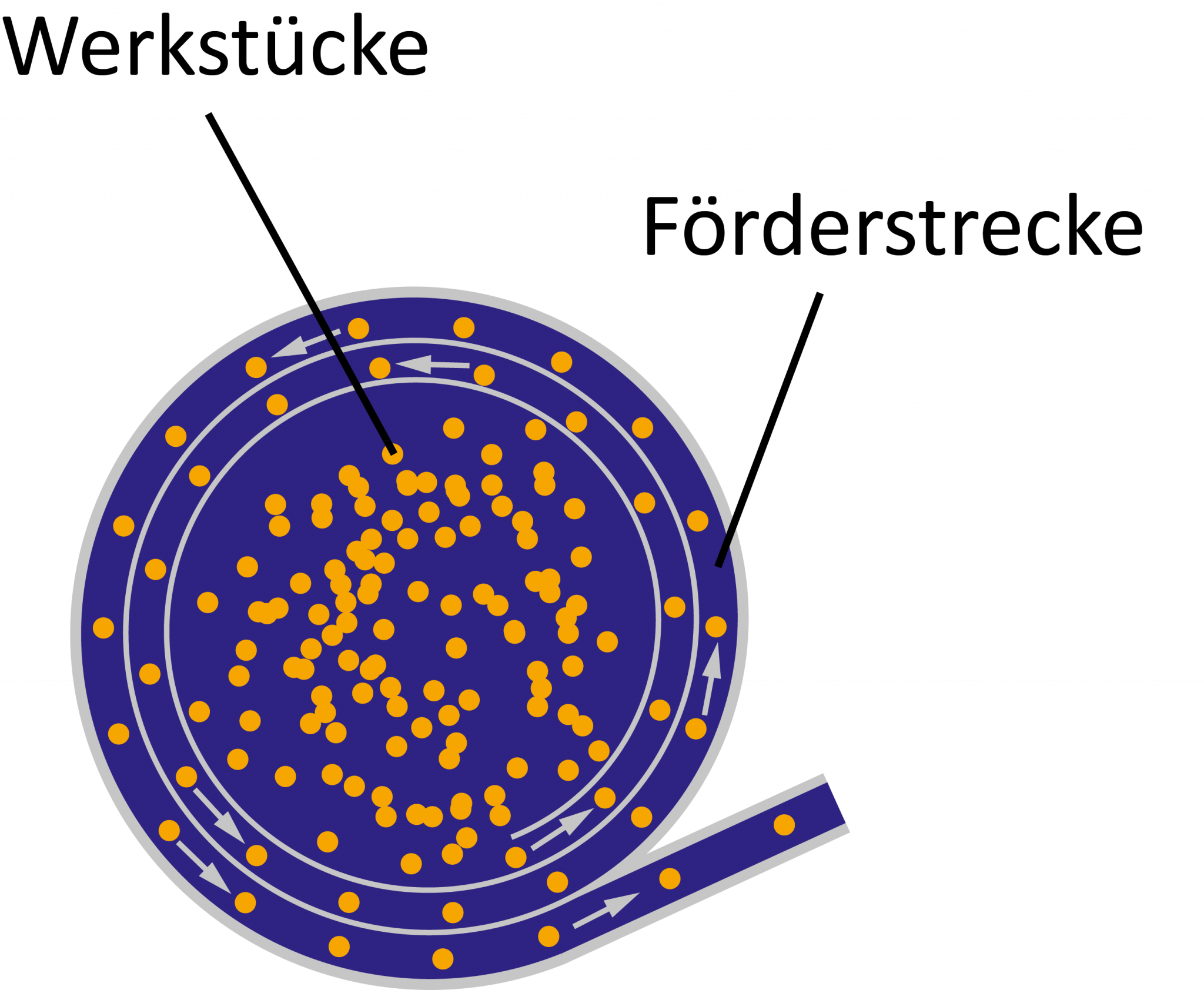

Unser MackSmaTec-Wiki bietet Ihnen die Möglichkeit schnell und einfach Begrifflichkeiten aus verschiedenen (Maschinenbau-)Branchen nachzuschlagen. Bei der Auswahl an Begriffen haben wir uns auf unsere vier Geschäftsbereiche fokussiert. Von Abrasivmittel und Aufschrumpfen bis Wendelförderer geben wir Ihnen eine Antwort auf die Frage: Was ist das eigentlich?

Schrumpfen bzw. Aufschrumpfen

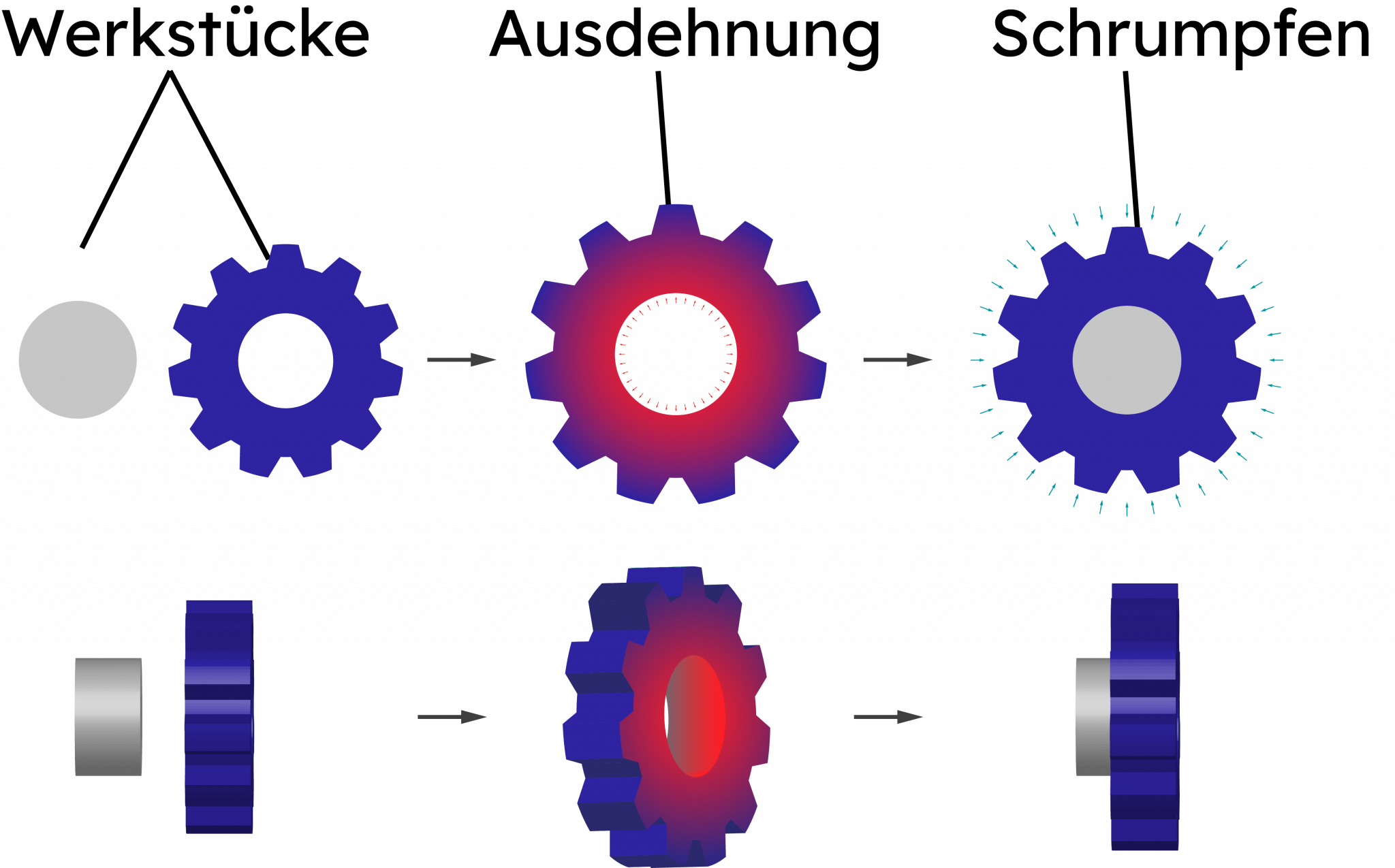

Das Schrumpfen bzw. Aufschrumpfen bezeichnet ein Fügeverfahren, welches auf dem Prinzip der Wärmeausdehnung basiert. Es kommt besonders häufig im Maschinenbau zum Einsatz und kann mit weiteren Fügeverfahren, wie etwa dem Kalt- oder Eindehnen kombiniert werden. Beim Schrumpfen bzw. Aufschrumpfen entstehen nahtlose, dauerhafte Verbindungen, die selbst stärksten Beanspruchungen standhalten können. Entsprechend erweist sich das Schrumpfen in vielen industriellen Bereichen als lohnenswerte Alternative zu Fügeverfahren, bei denen Materialverletzungen stattfinden (zum Beispiel Löten, Schrauben oder Schweißen).

Wie funktioniert das Schrumpfen bzw. Aufschrumpfen?

Dem industriellen Fügeverfahren des Schrumpfens liegt ein einfaches physikalisches Prinzip zugrunde: Bestimmte Materialien dehnen sich bei hohen Temperaturen aus und ziehen sich bei Kälte wieder zusammen. Um also zwei Bauteile über das Schrumpfen miteinander zu verbinden, wird eines der beiden Bauteile bis zu dem Grad erwärmt, an dem es sich ausdehnt. Anschließend wird das gedehnte und erwärmte Bauteil über das nicht erwärmte Bauteil gezogen und abgekühlt. Mit sinkenden Temperaturen schrumpft das zuvor erhitzte Bauteil zu seiner ursprünglichen Größe zusammen und umschließt seinen Fügepartner dabei dauerhaft und fest. Diese Verbindung kann erst wieder gelöst werden, wenn das Bauteil erneut erhitzt wird. Hierbei gilt es zu beachten, dass nur das äußere, umschließende Bauteil erwärmt wird. Dehnt sich das umschlossene Bauteil ebenfalls aus, kommt es nicht zu einer Lösung der Schrumpfverbindung. Dies wird in der Regel mithilfe von Induktionserwärmung erreicht, weil diese die Bauteile punktgenau und materialschonend erhitzen kann

Wo wird das Schrumpfen angewendet?

Das Schrumpfen wird normalerweise nur in Verbindung mit Metallteilen angewendet. Da sichergestellt werden muss, dass die Materialeigenschaften nach dem Ausdehnen und Erkalten auf gleichem Niveau stabil bleiben, sind andere Materialien für das Schrumpfen nicht geeignet. Durch Aufschrumpfen miteinander verbunden werden häufig Ringe, Zahnräder, Wellen oder Rohre. Besondere Einsatzgebiete dieses Fügeverfahrens finden sich neben dem Maschinenbau auch im Schiffbau, der Automobilindustrie sowie der Luft- und Raumfahrttechnik. Ein klassisches Beispiel ist die Herstellung von Eisenbahnrädern, bei denen Radreifen und Welle über das Aufschrumpfen dauerhaft und stabil gefügt werden. Auch viele Werkzeuge werden mittlerweile mit einer Schrumpftechnik ausgestattet: Auf diese Weise lassen sich beispielsweise Aufsätze im Futter präzise befestigen.

Welche Vor- und Nachteile besitzt das Schrumpfen?

Das Schrumpfen bzw. Aufschrumpfen ist ein relativ simpel aufgebautes Fügeverfahren, bei dem keine zusätzlichen Hilfsmittel wie Klebstoffe benötigt werden. Darüber hinaus finden keine Materialverletzungen statt. Die beim Schrumpfen entstehende Verbindung ist stabil und dauerhaft, kann jedoch durch erneutes gezieltes Erwärmen des Fügepartners auch wieder gelöst werden. Allerdings ist das Verfahren ausschließlich für Metalle geeignet, die sich bei Wärme ausdehnen können, ohne dabei an Materialeigenschaften einzubüßen. Deshalb muss beim Schrumpfen unbedingt auf die Einhaltung der korrekten Temperaturen geachtet werden. Überdies ist eine gleichmäßige Erwärmung entscheidend, damit es nicht zu unterschiedlichen Ausdehnungsgraden und damit zu Materialverzug kommt.

BEV – Battery Electric Vehicle

BEV ist die Abkürzung für „Battery Electric Vehicle“, die sich mittlerweile auch im Deutschen eingebürgert hat. Alternativ wird häufig vom batterieelektrischen Fahrzeug oder batterieelektrischem Auto gesprochen. Gemeint ist hiermit immer ein reines Elektrofahrzeug, das komplett ohne Verbrennungsmotor auskommt und die für seinen Betrieb benötigte Energie ausschließlich über eine im Fahrzeug verbaute Batterie bezieht. Im Gegensatz zu anderen Elektrofahrzeugen, wie etwa dem HEV (Hybrid Electric Vehicle) oder dem FCEV (Fuel Cell Electric Vehicle) werden BEV deshalb oftmals als „reine Elektrofahrzeuge“ bezeichnet.

Was ist ein BEV?

Ein Battery Electric Vehicle ist ein Fahrzeug, das ausschließlich durch Batteriestrom betrieben wird. Es steht dementsprechend anderen sogenannten Elektroautos, wie beispielsweise den Hybrid Electric Vehicles oder den Plug-In Hybrid Electric Vehicles, die häufig mit einem Energiemix unterwegs sind, gegenüber. Im BEV hingegen ist einzig ein elektrischer Antriebsmotor verbaut, der die benötigte Energie aus einer leistungsstarken Batterie erhält. Diese wiederum wird extern aufgeladen – etwa an der Energietanksäule oder an der heimischen Wallbox. Ein Teil, der über die Batterie zur Verfügung gestellten Energie, wird zudem durch das Fahrzeug selbst generiert: Beim Bremsen findet eine sogenannte Energierückgewinnung (Rekuperation) statt, die dafür sorgt, dass sich der Akku bei jeder Bremsung wieder etwas auflädt. Der Effekt kann allerdings nicht genutzt werden, um das BEV allein mithilfe der Rückgewinnung zu betreiben.

Welche Vorteile bietet das BEV?

Komplett batterieelektrische Autos bieten eine ganze Reihe von Vorteilen. So ist ein BEV abgasfrei unterwegs, weil es ohne Verbrennungsmotor läuft. Wer sein Battery Electric Vehicle darüber hinaus mit Strom aus erneuerbaren Energien betreibt, spart zusätzlich große Mengen an CO2 ein. Über den gesamten Lebenszyklus hinweg haben batterieelektrische Fahrzeuge gegenüber Autos mit Benzin- oder Dieselmotor entsprechend eine deutlich bessere Bilanz hinsichtlich der Treibhausgasemissionen. Darüber hinaus verursachen BEVs sehr viel weniger Kosten bei Pflege und Wartung: Es gibt keine Zündkerzen und kein Motoröl mehr, die gewechselt werden müssen, die Bremsen werden weniger beansprucht und auch ein Getriebe gehört bei den reinen Elektrofahrzeugen der Vergangenheit an. Weiterer Pluspunkt: Elektromotoren verursachen nicht nur weniger Abgase, sondern auch einen geringeren Geräuschpegel. Insbesondere in Städten, aber auch in ländlichen Wohngebieten, kann das zu mehr Lebensqualität beitragen.

Welche Nachteile hat das BEV?

Batterieelektrische Fahrzeuge bieten zwar etliche Vorteile, stehen jedoch aufgrund verschiedener Aspekte auch immer wieder in der Kritik. Da sind zum Beispiel die hohen Energiekosten und der Verbrauch wertvoller Ressourcen, die bei der Herstellung der benötigten Batterien anfallen. Darüber hinaus existiert bei vielen BEVs noch immer das Problem der begrenzten Reichweite sowie der Temperaturanfälligkeit der Batterien. Auch die langen Ladezeiten sowie die teilweise mangelhafte Infrastruktur bezüglich bereitstehender Ladesäulen wird immer wieder bemängelt. Die meisten dieser Kritikpunkte sind jedoch darauf zurückzuführen, dass die Entwicklung der BEVs bis dato noch in den Kinderschuhen steckt. So gehen Experten davon aus, dass die ohnehin bereits überzeugende Umweltfreundlichkeit der Fahrzeuge durch zukünftige Entwicklungen weiter ausgebaut werden kann.

Brennstoffzelle

In einer Brennstoffzelle reagiert ein Brennstoff mit einem Oxidationsmittel. Dabei entstehen elektrische Energie, Wärme und Wasser als Reaktionsprodukte. Brennstoffzellen werden heute vor allem mit Wasserstoff als Brennstoff betrieben. Nicht selten spricht man deshalb auch von einer Wasserstoffzelle. Anwendungsgebiete finden sich beispielsweise bei Brennstoffzellenheizungen, in Schiff- und Raumfahrt sowie im Schienenverkehr. Darüber hinaus sind sie seit einigen Jahren als Antrieb für Fahrzeuge im Gespräch – hier sollen die Brennstoffzellen helfen, einen klimafreundlichen Straßenverkehr zu etablieren.

Was ist eine Brennstoffzelle?

Eine Brennstoffzelle ist eine galvanische Zelle, deren Hauptaufgabe es ist, thermische und elektrische Energie zu erzeugen. Dafür wird keinerlei zusätzliche Energie von außen benötigt, weshalb man auch von einer sogenannten „kalten Verbrennung“ spricht. In der Brennstoffzelle wird Wasserstoff über den Tank zur Anode geführt, während Sauerstoff aus der Umgebungsluft an die Kathode gelangt. Bei der Reaktion beider Stoffe miteinander kommt es zur Freisetzung thermischer und elektrischer Energie, ohne das Stickoxide erzeugt werden. Durch die permanente Zuführung von Wasserstoff und Sauerstoff ist zudem eine kontinuierliche Energieerzeugung möglich. Wichtig: Eine Brennstoffzelle ist ein Energiewandler und kein Energiespeicher – hierin besteht der entscheidende Unterschied zu einer Batterie.

Gescheiterte Einsatzgebiete von Brennstoffzellen

Brennstoffzellen bieten die Möglichkeit einer autarken Energieerzeugung bei besonders geringem Gewicht. Das ist in vielen Bereich ein Vorteil, weshalb die Technologie beispielsweise in der Luft- und Raumfahrt genutzt wird. Viele Unternehmen wollten die Brennstoffzelle deshalb auch als mobile Energieversorgung für elektronische Geräte einführen. Im Raum standen beispielsweise Lösungen für portable Aufladegeräte für Smartphones, die über eine Brennstoffzelle unterwegs geladen werden sollten. Zu tatsächlichen Markteinführungen ist es bislang allerdings nicht gekommen. Experten gehen zudem davon aus, dass sich die Nachfrage nach Brennstoffzellen für die Versorgung von elektronischen Kleingeräten vermutlich nicht durchsetzen wird. Stattdessen eingesetzte Batterien erweisen sich bereits als klein, kompakt und leistungsstark genug.

Brennstoffzellen in Kraftfahrzeugen

Brennstoffzellen stehen als Alternative zu klassischen Verbrennungsmotoren im Raum. In Deutschland werden derzeit zwar die batterieelektrischen Fahrzeuge (BEV) favorisiert, in Japan wiederum spielt die Brennstoffzelle beim Thema E-Mobilität eine größere Rolle. Hier gelten Fahrzeuge mit Brennstoffzelle als wichtige Alternative auf dem Weg hin zur Energiewende und sind als Brennstoffzellen-Fahrzeuge bzw. Fuel Cell Electric Vehicle (FCEV) auf den Straßen unterwegs. Im Vergleich zu klassischen Elektroautos mit Batterie überzeugen die Fahrzeuge mit einer Brennstoffzelle durch kürzere Ladezeiten und größere Reichweiten. Nachteile sind jedoch, dass vor allem grüner Wasserstoff für den Betrieb der Brennstoffzellen bislang noch nicht (ausreichend) verfügbar ist und dass die kostengünstige serienmäßige Produktion von Autos mit Brennstoffzelle noch auf sich warten lässt.

Vorteile der Brennstoffzelle

Wenn es um die Vorteile von Brennstoffzellen geht, muss zunächst geprüft werden, womit die Brennstoffzelle verglichen wird. Als Antrieb in einem Kraftfahrzeug bietet die Brennstoffzelle gegenüber Dieselmotoren eine Reihe von Vorteilen – allein der reduzierte CO2-Ausstoß ist bemerkenswert. Beim Vergleich einer Brennstoffzelle mit einer herkömmlichen Batterie sind die Unterschiede dagegen nicht mehr ganz so groß: Brennstoffzellen bieten den Vorteil eines geringeren Gewichts, sind dafür aber mit deutlich höheren Investitionskosten verbunden.

Mit Blick auf die Autoindustrie kann es eine Chance sein, Batterie- und Brennstoffzellentechnik nicht separat als konkurrierende Angebote zu betrachten, sondern die Vorteile möglicher Hybridformen zu erkennen. Insbesondere für große, schwere Fahrzeuge sind Brennstoffzellen nach Meinung einiger Experten jedoch von vornherein die bessere Wahl – die zusätzliche Belastung durch schwere Batterien kann mit ihrer Hilfe umgangen werden.

CAD: Rechnerunterstütztes Konstruieren nach Maß

Die Abkürzung CAD steht für den englischen Begriff computer-aided design, hinter dem sich das auf Deutsch etwas sperrig klingende Konzept des rechnergestützten Konstruierens verbirgt. Einfacher gesagt: Eine CAD-Software ermöglicht das Konstruieren von Objekten mithilfe verschiedenster Daten an einem Computer. Anstatt das Objekt von Hand zeichnen zu müssen, können die komplette Modellierung oder auch nur die Gestaltung von Teilaspekten am Rechner vorgenommen werden. Wie eng oder wie weit die Begriffsdefinition reicht, ist dabei Auslegungssache. Insbesondere im Bereich technischer Zeichnungen sowie der technischen Dokumentation sind CAD (ebenso wie CADD)-Systeme und -Programme überaus hilfreich. Sie sorgen nicht nur für ein Plus an Flexibilität und Präzision, sondern helfen zudem Einsparpotentiale dank schnellerer Ergebnisse umzusetzen.

CAD-Software: Wie funktionieren CAD-Programme und wo werden sie genutzt?

Wer heute beispielsweise im Bereich der CNC-Lohnfertigung aktiv ist, kommt um die Nutzung von CAD-Software eigentlich kaum noch herum. Denn die CAD-Software ermöglicht es die Konstruktionsvorgaben direkt an das CNC-Gerät zu übertragen und spart dadurch zahlreiche Zwischenschritte ein. Parallel dazu werden Übertragungsfehler ausgeschlossen. Wie genau eine CAD-Software funktioniert, ist vom jeweiligen Hersteller und dem Anwendungsbereich abhängig. In industriellen Branchen werden CAD-Programme beispielsweise für die Konstruktion von Modellen oder für deren Überprüfung genutzt. Möglich ist es mithilfe von CAD sowohl 2D- als auch 3D-Modelle anzufertigen. Diese lassen sich, in Abhängigkeit von der jeweiligen Software, unter realen Bedingungen im virtuellen Raum überprüfen. So können beispielsweise Schwachstellen oder Fehler identifiziert und behoben werden, noch bevor die Kosten in den Bau der Prototypen investiert werden. Dank dieser umfangreichen Anwendungsmöglichkeiten greifen heutzutage praktisch alle Branchen auf CAD zurück: von der Automobilindustrie über den Sondermaschinenbau bis hin zu Medizintechnik und der Verpackungsindustrie.

Wo liegen die Vorteile vom CAD?

Einige Vorteile von CAD, also dem computer-aided design, wurden bereits benannt. Doch am meisten stechen die zeitsparenden, anpassungsfähigen und akkuraten Arbeitsmöglichkeiten durch die Nutzung einer CAD-Software hervor. Die Identifikation von Fehlern, die Anpassung an sich verändernde Bedingungen sowie die sofortige Speicherung sämtlicher technischer Daten und Informationen rund um den Fertigungsprozess bieten mehr Übersichtlichkeit und eine schnellere Bearbeitung von Aufgaben. Darüber hinaus weiß außerdem die Kompatibilität einzelner Systeme zu überzeugen: Hier ist vor allem die Zusammenarbeit zwischen CAD und CNC zu benennen.

Chaku-Chaku – Arbeitsorganisationsmodell zur Produktivitätssteigerung

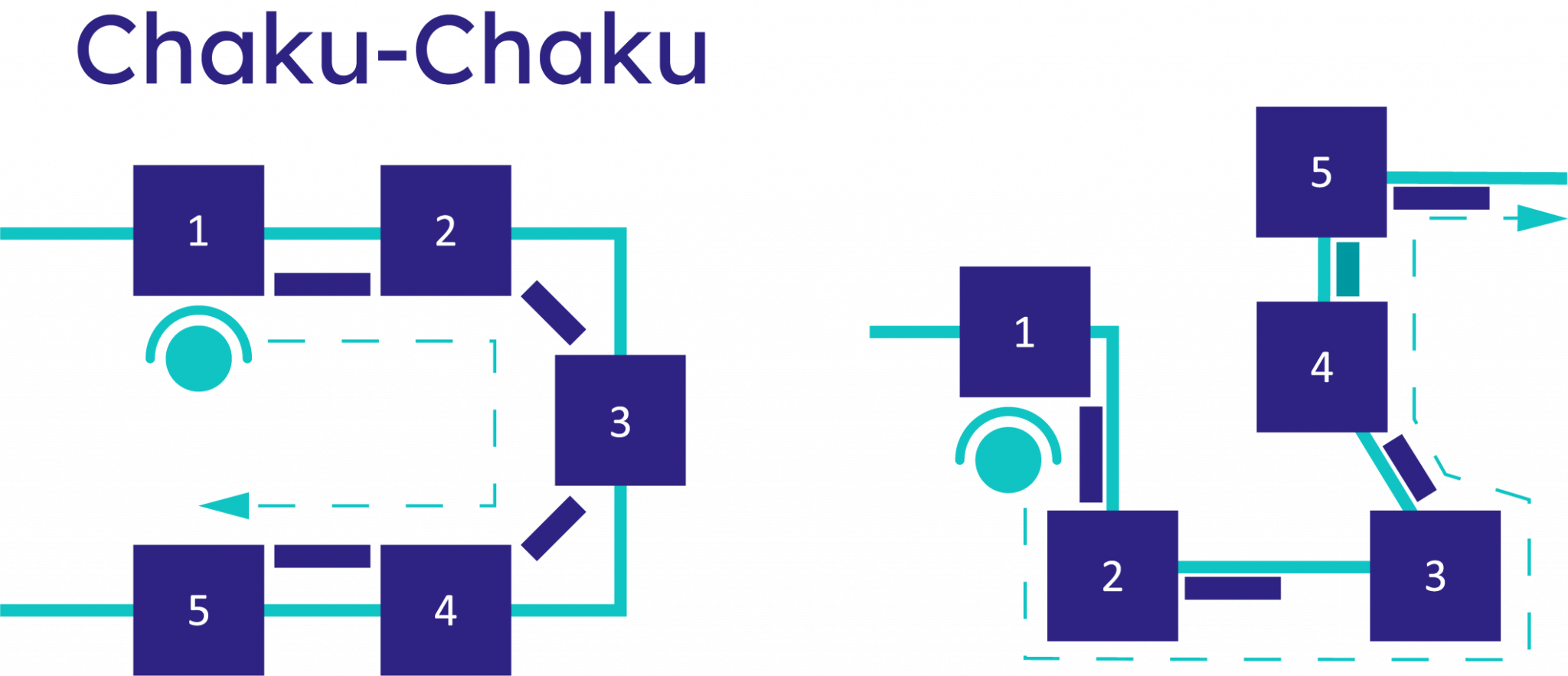

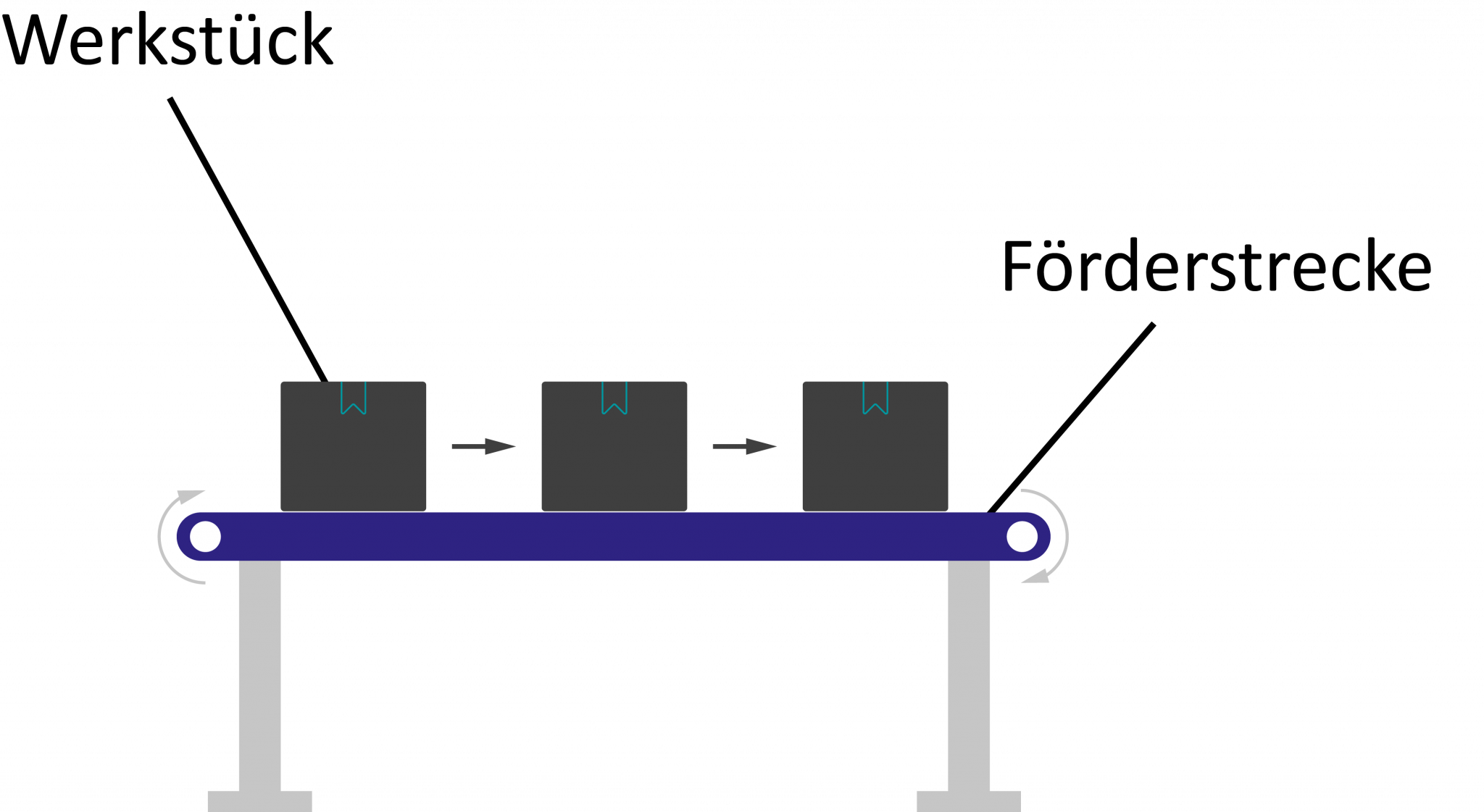

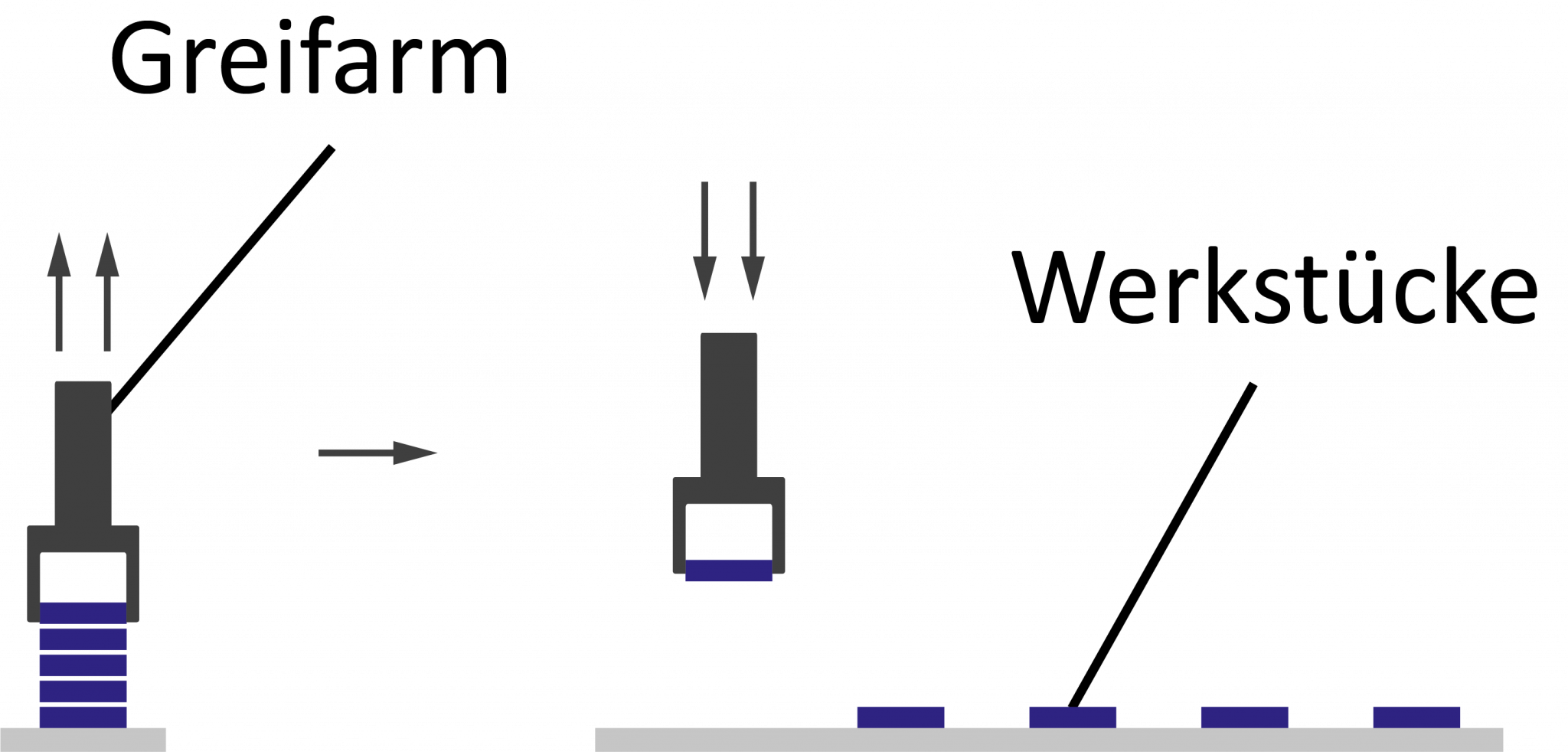

Chaku-Chaku ist ein Arbeitsorganisationsmodell, dessen Bezeichnung dem Japanischen entnommen wurde und sich auf Deutsch wörtlich mit „laden, laden“ übersetzen lässt. Alternativ wird hierzulande häufig auch die Bezeichnung „Fließprinzip“ verwendet. Arbeitsorganisationsmodelle wie die Chaku-Chaku-Linie haben in der Industrie den Anspruch eine größere Standardisierung sowie eine verbesserte Prozesskontrolle zu erreichen. Hieraus soll sich langfristig eine Produktivitätssteigerung in Kombination mit einem Anwachsen der Gewinnmarge ergeben. Chaku-Chaku kann als Erweiterung oder Weiterentwicklung zum One-Piece-Flow-Modell verstanden werden.

Hinter Chaku-Chaku verbirgt sich ein Modell der Fließ- und Reihenproduktion, bei dem es darum geht sämtliche Arbeitsplätze, die für die Herstellung eines Produkts benötigt werden, so aufzustellen, dass zwischen ihnen minimal kurze Wege bestehen. Auf diese Weise ergibt sich häufig eine Aufstellung der Arbeitsstationen, die mit Blick auf die Form an ein U oder ein Omega erinnert. Dank dieser Aufstellung wird es möglich, dass ein einzelner Mitarbeiter mehrere Maschinen bzw. Arbeitsstationen gleichzeitig bzw. parallel bedient. Er ist hierbei in der Regel lediglich für das Be- und Entladen der jeweiligen Maschinen sowie für den Transport der Produkte von einer Station zur nächsten verantwortlich. Die Maschine selbst erledigt ihre Aufgabe ohne das Zutun des Mitarbeiters. Je nach Komplexität ist es möglich eine Chaku-Chaku-Linie auch mit mehreren Mitarbeitern zu bestücken, denen jeweils einzelne Aufgabenbereiche zugeordnet werden. In der Praxis haben sich Modelle des Chaku-Chaku mit ein bis drei Arbeitskräften als erfolgreich realisierbar erwiesen.

Wo liegen potentielle Vorteile von Chaku-Chaku?

Durch den Verzicht auf lange Transportwege zwischen einzelnen Arbeitsstationen werden Zeitverluste bei der Herstellung eines Produkts minimiert. Gleichzeitig werden teure und komplexe Verkettungsmaschinen obsolet. Diese müssen nicht nur nicht länger angeschafft werden, sondern können unter Umständen sogar abgebaut werden. Innerhalb der Chaku-Chaku-Linie lassen sich je nach Produkt zudem auch Handarbeitsplätze integrieren. Dies kann ebenfalls dabei helfen teure Maschinen einzusparen oder abzubauen. Da das Beladen und Starten der einzelnen Maschinen an den jeweiligen Arbeitsstationen durch den oder die Mitarbeiter erfolgt, können unterschiedlich schnell bzw. langsam arbeitende Maschinen aufeinander abgestimmt werden. Das führt zu einer verbesserten zeitlichen Koordination ohne unerwünschte Verluste. In diesem Fall muss allerdings eingeplant werden, dass innerhalb der Chaku-Chaku-Linie Stationen für die Zwischenlagerung teilfertiger Produkte einzurichten sind.

Ein weiterer Vorteil beim Chaku-Chaku liegt in der verkürzten Einarbeitungszeit der innerhalb der Fließarbeit beschäftigen Mitarbeiter. Diese müssen in der Regel nur wenig komplexe Aufgabenstellungen bewältigen und sich lediglich um das Be- und Entladen der Maschinen kümmern. Aufwendige Schulungen entfallen genauso wie die Notwendigkeit einer Anstellung von Fachkräften. Auch dies wirkt sich langfristig kostensparend aus.

Wo liegen potentielle Nachteile von Chaku-Chaku?

Einige der vorab angesprochenen Vorteile von Chaku-Chaku können unter spezifischen Gesichtspunkten auch als Kritikpunkte angeführt werden. Diesbezüglich wäre zum einen die Monotonie der vom Mitarbeiter geforderten Tätigkeit, die zu stark einseitigen Belastungen und dementsprechend gesundheitlichen Nachteilen führen kann, zu benennen. Da zudem die Arbeitszeiten in der Chaku-Chaku-Linie beschleunigt werden, kommen Stress und physische Belastungen hinzu.

Parallel dazu kann ebenfalls der Verzicht auf ausgebildete Fachkräfte als langfristig problematisch angesehen werden. Mitarbeiter, die in einer Chaku-Chaku-Linie arbeiten, werden oft innerhalb kürzester Zeit eingearbeitet und benötigen für ihre Tätigkeiten in der Regel keine spezifische Ausbildung. Aus Arbeitnehmersicht ist das bedenklich, weil das Lohnniveau sinkt und auch eine Lohnsteigerung nur schwer möglich ist. Zusätzliche Qualifikationen haben auf die individuell vorgesehene Tätigkeit innerhalb der Chaku-Chaku-Linie aus lohnperspektivischer Sicht praktisch keine Auswirkungen. Gerade deshalb setzen sich Gewerkschaften und Betriebsräte häufig gegen eine Umsetzung des Chaku-Chaku-Modells ein.

Crimpen

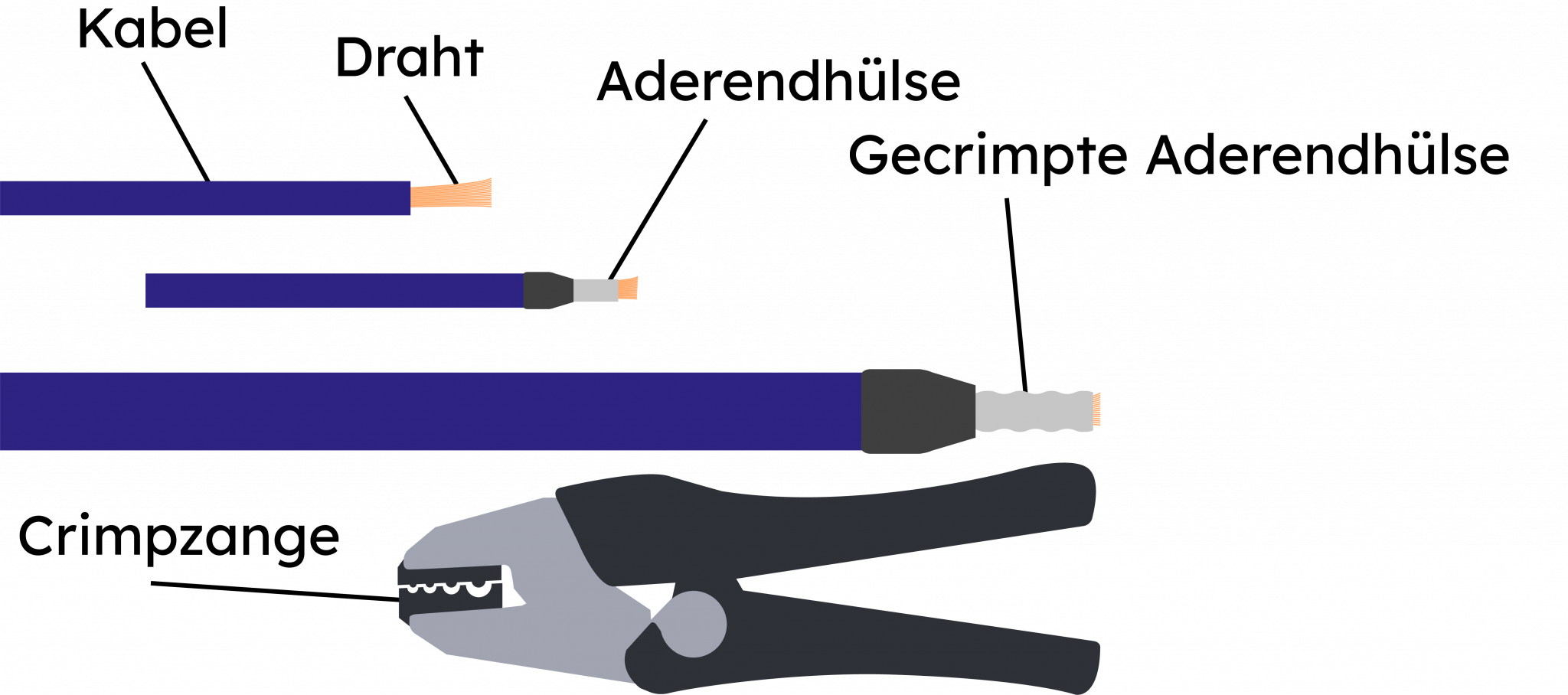

Das Crimpen gehört zu den Fügeverfahren und wird häufig als Alternative zum Löten oder Schweißen genutzt. Bevorzugt kommt das Crimpen zur Anwendung, wenn es um die Herstellung elektrischer Verbindungen geht. Ein Beispiel hierfür ist das Anbringen eines Steckers an einem Kabel inklusive der korrekten Verbindung zwischen den Adern des Kabels und den Steckerkontakten. Der Vorteil gegenüber Löt- und Schweißverfahren besteht vor allem in der Schnelligkeit und Präzision. Aufgrund dessen hat sich das Crimpen inzwischen bei der seriellen Großfertigung vielfach durchgesetzt.

Wie funktioniert das Crimpen?

Das Funktionsprinzip des Crimpens ist relativ simpel: Mithilfe von Druck auf zwei Komponenten wird eine plastische Verformung zwischen diesen erzeugt, welche die beiden Komponenten miteinander verbindet. Hierfür verwendet man spezielles Werkzeug, wie zum Beispiel eine Crimpzange, und presst die beiden Komponenten quasi ineinander. Die Verbindung, die beim Crimpen entsteht, ist stabil und dauerhaft. In der industriellen Fertigung werden für das Crimpen meist Anschlagpressen oder Kabelkonfektionierungsautomaten eingesetzt. Entscheidend für das präzise Arbeiten sind sogenannte Crimpmatrizen. Diese sind auf die zu verbindenden Komponenten abgestimmt und prägen die Art der Verformung bzw. der Crimpverbindung maßgeblich. Wenn die Crimpmatrize nicht passgenau ist, kann eine dauerhaft stabile Verbindung zwischen den beiden Komponenten nicht gewährleistet werden.

Wo wird das Crimpen angewendet?

Das Crimpen kommt nicht nur bei der Herstellung von elektrischen Verbindungen zum Einsatz, sondern ist auch aus alltäglicheren Situationen bekannt. So werden zum Beispiel Nudelspezialitäten wie Ravioli oder Maultaschen gecrimpt. Auch im Büroalltag bedient man sich bisweilen dieses Fügeverfahrens, wenn beispielsweise das verschließende Siegel auf einer Urkunde mithilfe eines Crimpvorgangs aufgebracht wird. Im industriellen Sektor sind es vermehrt die HF-Elektronik und die Telekommunikation, die bevorzugt auf Crimpverbindungen setzen. Hier bietet das Crimpen vor allem den Vorteil, dass es die Verlegung von fertig konfektionierten Kabeln auch ohne Stecker ermöglicht. Dieser wird mithilfe des Crimpens erst nach dem Verlegen angebracht.

Was ist beim Crimpen wichtig?

Damit beim Crimpen wirklich eine dauerhaft stabile Verbindung zwischen zwei Komponenten hergestellt werden kann, ist es wichtig, dass das Crimpen mit ausreichend hohem Kraftaufwand durchgeführt wird. Anderenfalls kann es passieren, dass die plastische Verformung nur unvollständig eintritt und die Verbindung dadurch Schwachstellen aufweist. Wird hingegen ein zu hoher Kraftaufwand eingesetzt, kann es zu Beschädigungen der Komponenten kommen. Auch ein mangelhaftes oder unangepasstes Crimpwerkzeug kann eine mögliche Fehlerquelle sein: Sitzt die Crimpmatrize nicht korrekt auf den zu verbindenden Komponenten, kann dies eine fehlerhafte oder ungenügende Verpressung herbeiführen.

Welche Vorteile bietet das Crimpen?

Das Crimpen ermöglicht eine schnelle, präzise und stabile Verbindung zwischen zwei Komponenten. Diese kann als homogen, gasdicht sowie elektrisch und mechanisch sicher eingestuft werden – sofern das Crimpen korrekt ausgeführt wird.

Dichtheit

Dichtheit bzw. Dichtigkeit ist die Eigenschaft von Materialstrukturen gegenüber bestimmten Stoffen, Gasen, Flüssigkeiten oder auch Strahlung undurchlässig zu sein. Es handelt sich hierbei um ein relatives Konzept, denn absolute Dichtheit kann es nicht geben. Stattdessen ist Dichtheit immer in Relation zum untersuchten Material, dem Aufbau und der durchdringenden „Substanz“ zu bewerten. So erweist sich beispielsweise ein Wasserrohr so lange als dicht, bis der Druck im Inneren zu hoch wird – dann kann das Rohr Risse aufweisen und es tritt Wasser durch die Leckage. Gegenüber Strahlung hingegen besitzt das Wasserrohr vermutlich von vornherein keine Dichtheit. Ob und inwiefern eine Materialstruktur Dichtheit aufweist, wird mithilfe einer Dichtheitsprüfung bzw. Dichtigkeitsprüfung erhoben. Insbesondere in der Produktion gehören Prüfungen der Dichtheit zum Alltag.

Warum ist Dichtheit so wichtig?

In der Produktion sind Dichtheitsprüfungen im Rahmen der Qualitätskontrolle unverzichtbar. Die zerstörungsfreie Prüfmethode wird mitunter auch als Lecktest bezeichnet und kommt bei Systemen und Bauteilen für unterschiedlichste Branchen zum Einsatz. Die Dichtheit eines Bauteils oder komplexen Systems zu prüfen, kann aus verschiedenen Gründen wichtig sein: So kann beispielsweise eine Dichtheitsprüfung während des Produktionsprozesses eine spätere, kostenintensive Nachbearbeitung von Bauteilen verhindern. Zudem können bei der Verwendung von nicht ausreichend dichten Bauteilen und Systemen spätere Reparaturkosten entstehen. Darüber hinaus existieren in vielen Branche spezifische Normen und gesetzliche Richtlinien für die Dichtheit von Bauteilen – um diese zu erfüllen, ist eine Dichtheitsprüfung ebenfalls unumgänglich. Bestes Beispiel: Wenn etwa Rohrsysteme in einer Kühlanlage nicht ausreichend dicht sind, kann es zum Austritt von Gas oder Wasser kommen. Hierdurch können nicht nur hohe Schäden entstehen, sondern möglicherweise auch Unfälle verursacht oder Personen verletzt werden.

Wie prüft man die Dichtheit?

Dichtheitsprüfungen kommen in verschiedensten Produktionsprozessen zum Einsatz – deshalb existieren je nach Anwendungsfall spezifische Dichtheitsprüfverfahren, die meist als Vakuum- oder Überdruck-Verfahren umgesetzt werden. Die entsprechenden Vorgaben sind der DIN EN 1779 zu entnehmen. Typische Beispiele sind:

Werker-Wasserbad-Prüfung (Blasentest)

Wasserbadprüfung mit Ultraschallsensor

Differenzdruck-Prüfung

Ultraschall-Detektion

Dichtheitsprüfung mit Testgasen

Entscheidend ist, dass die Prüfung der Dichtheit eines Prüflings bereits in die Produktion integriert wird. So können teure Nachbearbeitungen in der Serienfertigung von vornherein verhindert werden. Damit die Prüfverfahren jedoch tatsächlich verlässliche Ergebnisse liefern, sollten die hierfür genutzten Geräte regelmäßig gewartet und gegebenenfalls neu justiert werden.

In welchen Branchen spielt die Dichtigkeit bei Bauteilen und Systemen eine Rolle?

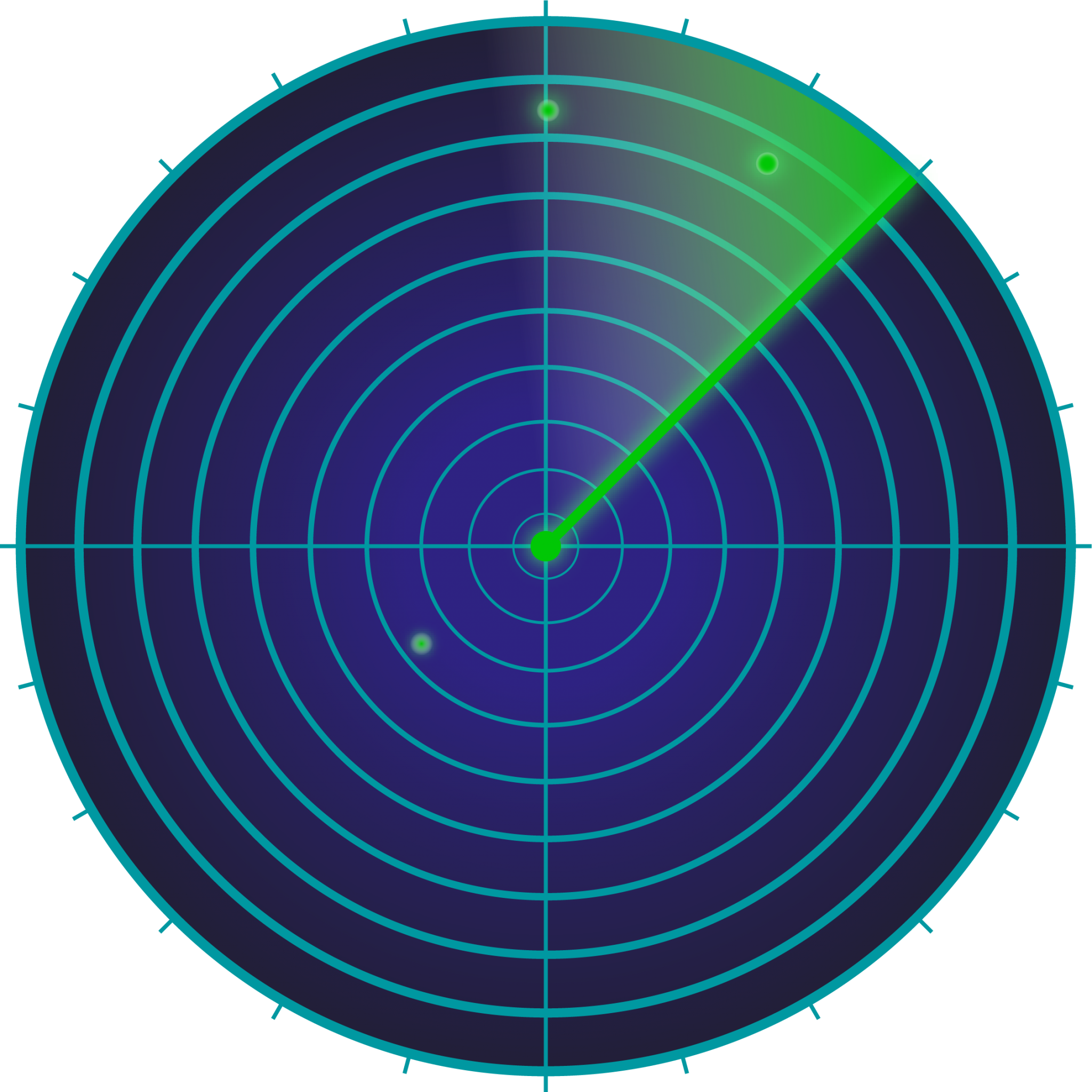

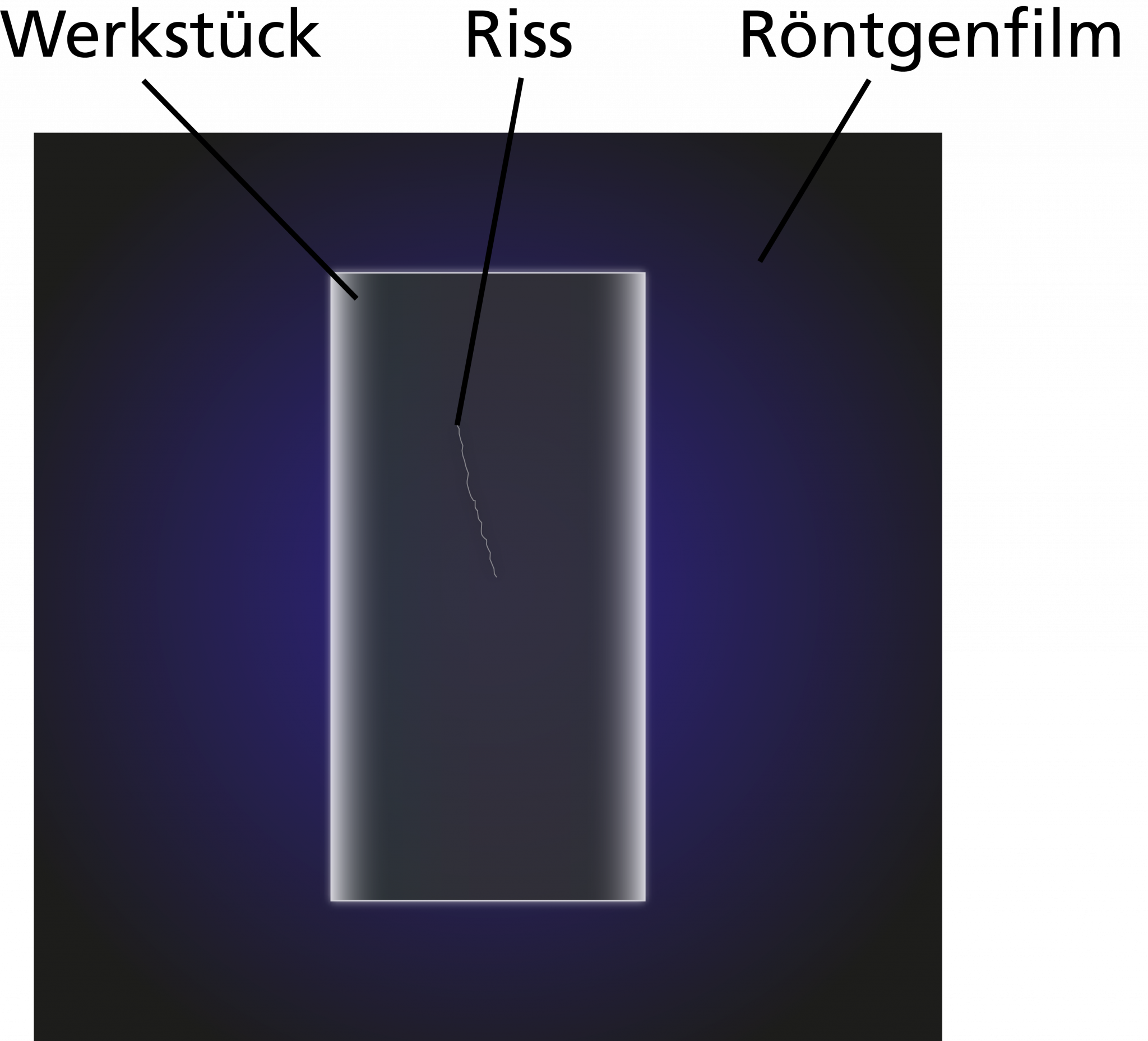

Dichtheitsprüfungen können heutzutage für (fast) jeden seriellen Produktionsprozess empfohlen werden. Zu den Branchen, die dichte Bauteile und Systeme benötigen, gehören beispielsweise der Automobilsektor, Schiffbau, Medizin- und Labortechnik, Luft- und Raumfahrtindustrie, Maschinenbau, Elektrotechnik und viele weitere. Weitere Messtechnologien, die in der industriellen Serienproduktion zum Einsatz kommen, sind unter anderem Drehmoment, Röntgen und Radar.

dpi – Punktdichte bei der Reproduktion von Bildern

dpi ist eine Abkürzung und steht für dots per inch. Auf Deutsch übersetzt bedeutet das wiederum "Punkte pro Zoll" und entspricht einer Angabe für die sogenannte Punktdichte. Mit der Punktdichte wird bei der Reproduktion von Bildern angegeben, wie detailgenau die Darstellung ausfällt. Für gewöhnlich gilt, dass eine höhere Punktdichte bzw. eine höherer dpi-Wert eine bessere Detailgenauigkeit repräsentiert. Bei der Bewertung der Qualität einer Reproduktion sind neben der Punktdichte noch weitere Faktoren entscheidend: Die Farbtiefe sowie die Schärfe des Bildes spielen eine wichtige Rolle. Im Zusammenhang mit dem dpi-Wert wird häufig auch von Auflösung gesprochen.

dpi und weitere Maßeinheiten zur Punktdichte

Wenn es um die Punktdichte geht, spielen neben der Maßeinheit dpi unter Umständen noch weitere Einheiten eine Rolle. So gibt es noch dpcm bzw. dpc, was für "dots per centimetre" steht, oder ppi, was der Einheit "pixel per inch" entspricht. Auch die Einheit lpi "lines per inch" kann relevant werden. Je nachdem, für welchen Bereich die Punktdichte berechnet werden soll, kommen andere Parameter zum Tragen. Die Unterschiede zwischen dpi und dpc ergeben sich aufgrund der Differenz zwischen dem metrischen und dem angloamerikanischen Maßsystem. Sie bezeichnen jedoch im Grunde das Gleiche.

Der Unterschied zwischen den einzelnen Einheiten ist prinzipiell schnell erklärt: dpi und lpi sind vor allem für Druckverfahren relevant, während die Einheit ppi bei der digitalen Darstellung zum Tragen kommt. Dots bezeichnen konkrete Druckpunkte, während der Begriff Pixel digitale Bildpunkte bezeichnet. Wenn nun zum Beispiel mittels Inkjet-Verfahren ein Bild auf ein Trägermedium gedruckt werden soll, muss festgelegt werden, wie hoch der dpi-Wert ausfallen soll. Das geschieht mithilfe eines Rasters: Angegeben wird, wie viele Druckpunkte beim ausgewählten Verfahren auf dem Quadratzentimeter bzw. Quadratzoll Fläche landen. Hierfür wird der lpi-Wert zur Hilfe genommen, mit dem sich bestimmen lässt, wie viele Reihen von Druckpunkten auf dem Quadratzentimeter bzw. dem Quadratzoll Fläche abgebildet werden sollen. Je feiner das Raster, desto höher die Punktdichte. Wer nun aber denkt, dass es eine verbesserte Bildqualität mit sich bringt, wenn man dpi und lpi kontinuierlich nach oben schraubt, der täuscht sich. Tatsächlich ist die visuelle Wahrnehmung des menschlichen Auges limitiert und ein dpi-Wert oberhalb einer bestimmten Grenze ist nicht zweckdienlich.

Beste Auflösung mit Blick auf den dpi-Wert

Wenn es um die bestmögliche Auflösung bzw. den optimalen dpi-Wert für Druckvorgänge geht, spielen verschiedene Faktoren eine Rolle. Pauschale Angaben sind in der Regel nicht möglich. So ist es zum Beispiel bei besonders kleinen Druckvorlagen problemlos möglich einen niedrigeren dpi-Wert zu wählen als bei einer mittelgroßen Druckvorlage. Das liegt daran, dass das menschliche Auge dazu übergeht kleine Fehler automatisch auszugleichen. Bei einer großen Druckvorlage wiederum ist ein sehr ähnlicher Effekt bemerkbar: Die einzelnen Bildpunkte werden vom Auge zusammengezogen und verschwimmen zu einem großen Ganzen. Das gilt allerdings nur, wenn man sich im richtigen Abstand vor dem Bild befindet. Das ist etwa bei gedruckten Plakaten häufig der Fall. Bei der richtigen dpi-Auswahl kommt es demnach auf das individuelle Projekt an. Darüber hinaus sind verfahrenstechnische Limitierungen zu berücksichtigen. Beim Inkjet-Druck können beispielsweise Werte von 600 dpi gut erreicht werden, während bei anderen Druckverfahren nur geringere Druckauflösungen möglich sind.

Drahtbonden – ein Thermokompressionsverfahren für Elektronikbauteile

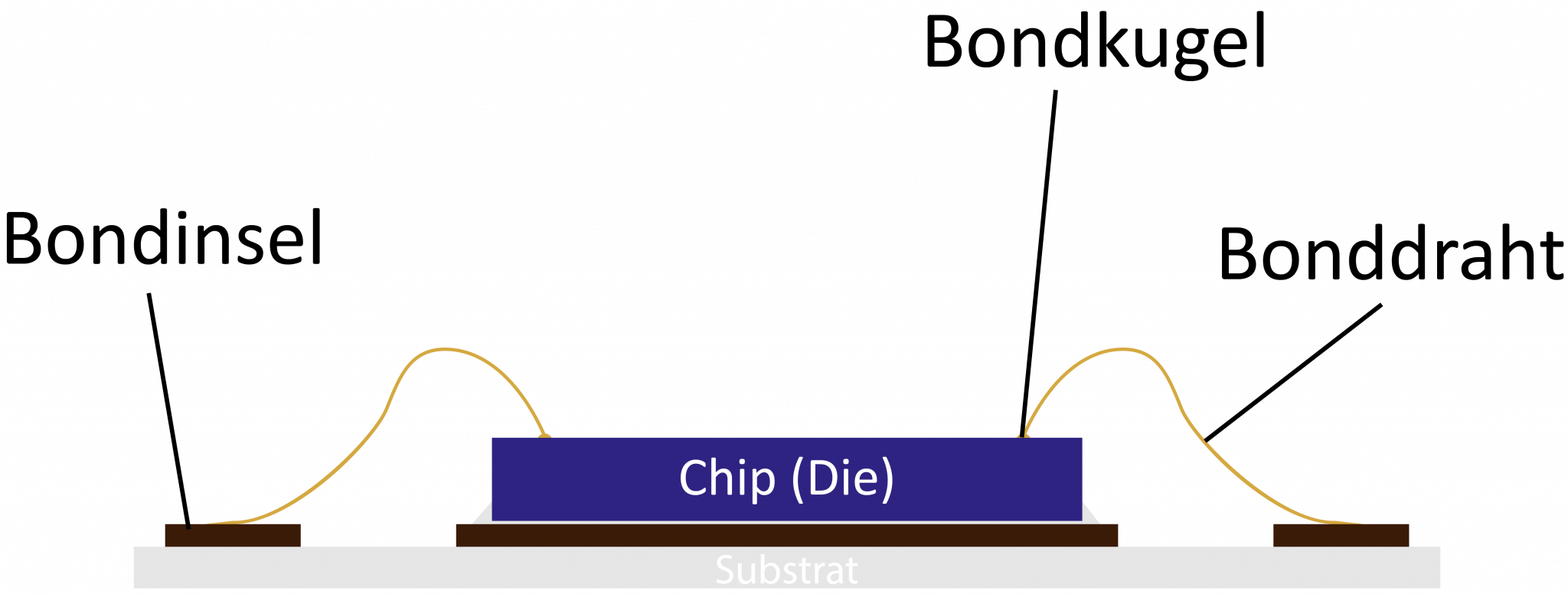

Beim Thermokompressionsverfahren oder auch Thermokompressionsschweißen handelt es sich um ein Schmelzschweißverfahren, welches insbesondere beim dauerhaften Zusammenfügen von empfindlichen Elektronikbauteilen wie dem Drahtbonden zum Einsatz kommt. Alternative Schweißverfahren, die ebenfalls eine dauerhafte Verbindung zweier Bauteile untereinander ermöglichen, kommen aufgrund verschiedener Gründe in diesem Bereich häufig nicht in Frage. Ein Beispiel hierfür ist das Laserschweißverfahren, welches in der Regel derart hohe Temperaturen erzeugt, dass elektronische Bauteile wie etwa Chips hierbei einen Schaden erleiden können. Das Thermokompressionsschweißen ist da anders: Es ähnelt im Prinzip dem Lichtbogenbolzenschweißen, weil es sich hierbei ebenfalls um ein Pressschweißverfahren handelt. Beim Thermokompressionsschweißen werden jedoch nicht die Kontaktpunkte an den Bauteilen selbst geschmolzen, sondern es wird vor allem bei elektronischen Bauteilen mit einem Draht gearbeitet. Daher rührt auch die spezifische Bezeichnung des Teilaufgabenbereichs "Drahtbonden". Wie genau das Verfahren funktioniert und welche Vorteile und Schwierigkeiten berücksichtigt werden müssen, wird nachfolgend erklärt.

Die Funktionsweise des Thermokompressionsschweißens beim Drahtbonden

Die nachfolgenden Ausführungen beziehen sich in erster Linie auf das Thermokompressionsschweißen, welches bei der Fertigung von Elektronikbauteilen zum Einsatz kommt. Hierbei spricht man auch vom sogenannten Drahtbonden, wobei vorrangig das Verfahren gemeint ist, bei dem Chips mit dem jeweiligen Gehäuse kontaktiert werden. Dafür wird zunächst ein feiner Golddraht durch eine sogenannte Kapillardüse geführt und dabei von unten über eine kontrollierte Hitzequelle erwärmt. Durch die Erwärmung schmilzt der Draht zu einer Kugel, die anschließend bei der ersten Schweißung auf die Kontaktstelle gepresst wird. Diese Kontaktstelle wird auch als Bondinsel bezeichnet. Um nun eine Verbindung mit einer weiteren Bondinsel bzw. Kontaktstelle herstellen zu können, wird die Kapillardüse wieder nach oben geführt und in einem Halbkreis auf die nächste Kontaktstelle gebracht. Dort erfolgt wiederum ein neuerliches Andrücken mit anschließendem Abschneiden des Drahtes. Verwendet wird beim Thermokompressionsschweißen im Zusammenhang mit Elektronikbauteilen bzw. dem Drahtbonden ausschließlich feiner Golddraht. Dieser wird bei Temperaturen von um die 350°C verarbeitet. Der Vorteil von Golddraht besteht darin, dass er resistent gegenüber Oxidationsvorgängen und damit für die Fertigung von Elektronikbauteilen geeignet ist. Theoretisch wäre es auch möglich andere Materialien zu verwenden, allerdings wäre dies nur mit großem technischen Aufwand möglich, der sich aus Kostensicht meist nicht rechtfertigen lässt.

Vor- und Nachteile vom Drahtbonden als Variante des Thermokompressionsschweißens

Bei der Fertigung von Elektronikbauteilen mithilfe des Thermokompressionsschweißens sind eine Reihe von Vor- und Nachteilen gegenüber anderen Verfahren und Methoden zu benennen. Gegenüber dem Laserschweißverfahren bringt das Thermokompressionsschweißen bzw. das Drahtbonden den Nachteil des Material- und Werkzeugverschleißes mit sich. Auf der anderen Seite sind die geringeren Arbeitstemperaturen, die beim Thermokompressionsschweißen erzeugt bzw. benötigt werden, den oftmals empfindlichen Bauteilen zuträglicher. Zu den weiteren Vorteilen neben dem niedrigen Wärmeeintrag gehören die kurzen Erhitzungszeiten sowie die Tatsache, dass die über das Thermokompressionsschweißen verbundenen Teile keine Verformungen erleiden. Die Festigkeit und Dauerhaftigkeit der Verbindung ist ebenfalls ein positives Merkmal dieses Verfahrens.

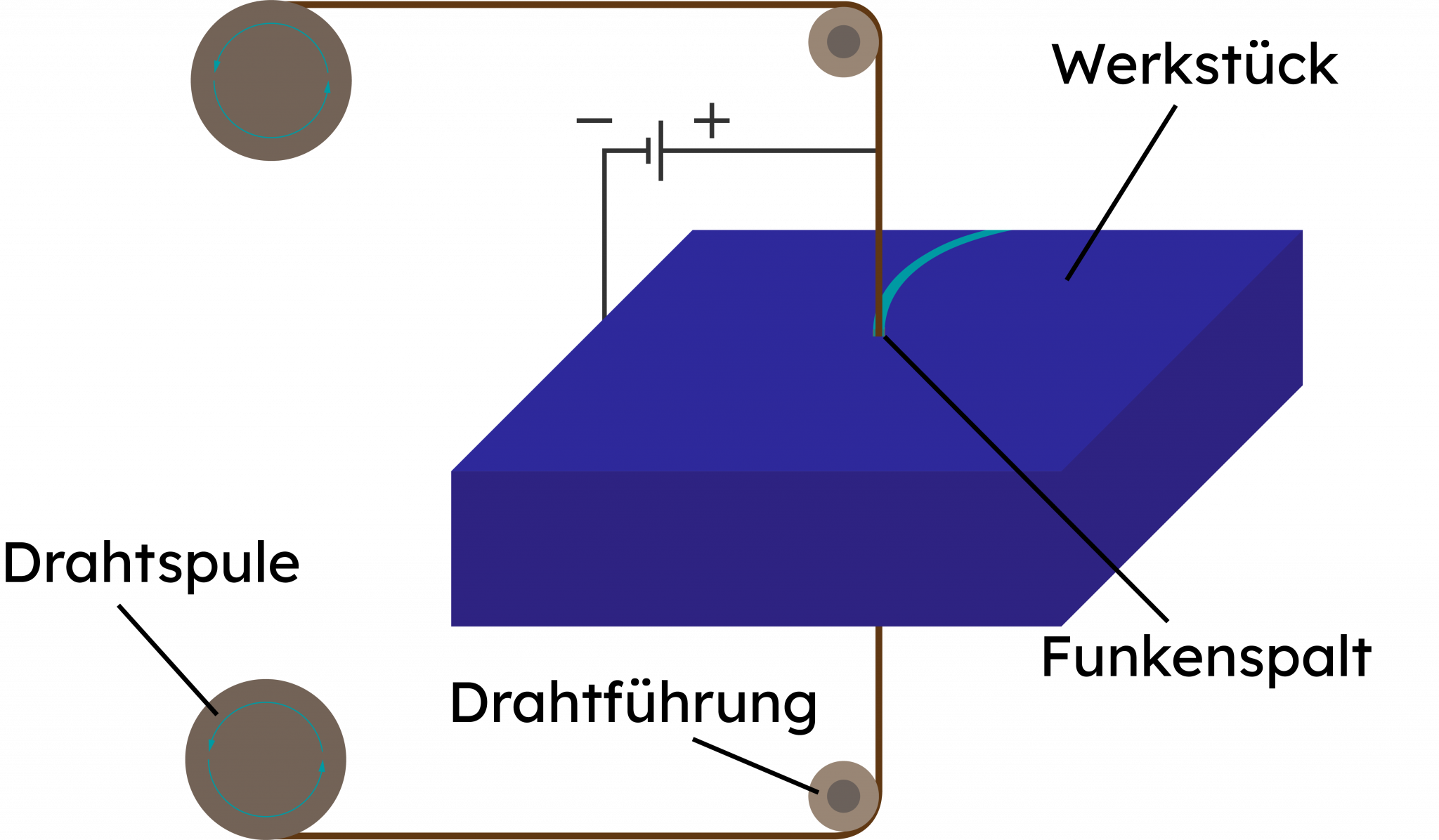

Drahterodieren – Schneidverfahren mit hoher Präzision

Das Drahterodieren gehört, ebenso wie das Senkerodieren, zu den abtragenden Fertigungsverfahren, die nach dem Prinzip der Funkenerosion arbeiten. Häufig wird in diesem Zusammenhang auch vom Drahtschneiden, Schneiderodieren oder der Drahterosion gesprochen. Das Bearbeitungsverfahren kommt in industriellen Fertigungsprozessen, beispielsweise als Alternative zum Fräsen, zum Einsatz. Drahterodieren zeichnet sich dadurch aus, dass elektrisch leitfähige Materialien mit höchster Genauigkeit und beachtlicher Schnittgeschwindigkeit bearbeitet werden können. Im Fokus des Aufgabenspektrums stehen bei der Drahterosion vor allem die Herstellung von Prototypen sowie Schnitt- und Stanzwerkzeugen.

Wie funktioniert das Drahterodieren?

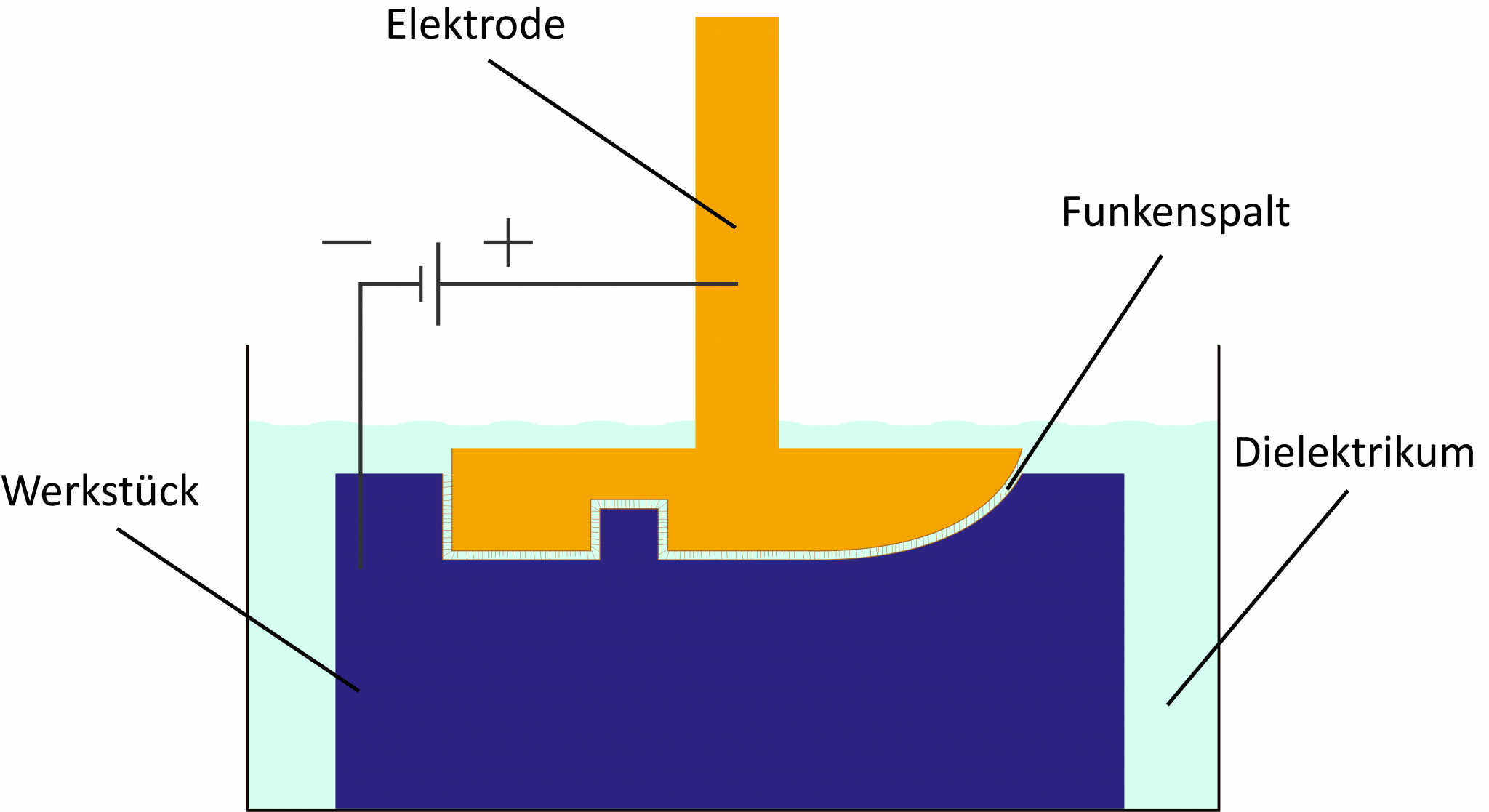

Beim Drahterodieren sind drei Elemente von besonderer Wichtigkeit: Drahtelektrode, Dielektrikumsbad und Werkstück. Sowohl das Werkstück als auch die Drahtelektrode befinden sich während des Schneidvorgangs im Dielektrikumsbad. Dieses wird mithilfe einer nicht leitenden Flüssigkeit hergestellt, wofür entweder deionisiertes Wasser oder spezielles Erodieröl zum Einsatz kommen. Teilweise wird alternativ zum Dielektrikumsbad ein Koaxialstrahl genutzt. Der Draht besteht in der Regel aus Messing, kann jedoch ebenso gut aus Kupfer oder Stahl gefertigt sein. Für das Drahterodieren werden normalerweise Draht-Elektroden mit einem Durchmesser zwischen 0.02 mm und 0.33 mm verwendet.

Der genaue Vorgang verläuft schließlich in drei Phasen: Zunächst werden die Drahtelektrode und das zu bearbeitende Material in einem vorab klar definierten Abstand zueinander gebracht. Wichtig ist, dass beide unterschiedlich geladen sind (Werkstück = Anode und Draht = Kathode). Nun wird mithilfe von elektrischen Spannungsimpulsen ein elektrisches Feld erzeugt (Zündphase) – und zwar genau dort, wo der Abstand zwischen Draht und Werkstück am geringsten ist. In diesem Feld findet eine Beschleunigung der elektrisch geladenen Teilchen statt, die zur Entstehung eines sichtbaren Funkens führt. Hierdurch entsteht große Hitze, die dafür sorgt, dass das Dielektrikum verdampft und das Material von Elektrode und Werkstück schmilzt. In der Folge bildet sich eine Gasblase, die sich wiederum mit Plasma anfüllt (Entladephase). Durch eine einsetzende Impulspause (Pausenphase) wird die Stromzufuhr unterbrochen, sodass die Blase implodiert. Hierbei wird das geschmolzene Material vom Werkstück gelöst und mit dem Dielektrikum abtransportiert. Pro Sekunde werden die Vorgänge von Zündphase zu Pausenphase je nach Maschine bis zu 100.000-mal wiederholt. Dabei entstehen Temperaturen von bis zu 40.000°C.

Wo liegen die Vorteile des Drahterodierens?

Das Drahterodieren gehört heute zum Standardverfahren in der formgebenden Fertigung. Dies liegt an den verschiedenen Vorteilen, die es mit sich bringt: So ist zum Beispiel das Zuschneiden äußerst komplexer Formen und kleinster Radien problemlos möglich. Extrem harte Materialien wie etwa Titan lassen sich genauso problemlos bearbeiten wie besonders dicke Werkstücke. Auch äußerst dünne Teile können unkompliziert geschnitten werden, weil es zwischen dem Werkstück und dem Werkzeug zu keinem Kontakt kommt. Der Verschleiß ist minimal, während gleichzeitig praktisch keine Nachbearbeitungskosten entstehen. Schließlich ist das Drahterodieren für perfekte Schnittkanten bekannt.

Nichtsdestotrotz sind nicht alle Materialien fürs Drahterodieren geeignet: Sie müssen leitfähig sein und eine hohe Qualität vorweisen. Anderenfalls sind die Schnittergebnisse gegebenenfalls nicht überzeugend. Außerdem sollten die Materialien wasserunempfindlich sein, weil sie gerade bei längeren Bearbeitungszeiten dauerhaft im Dielektrikum verbleiben müssen (Rostgefahr). Ebenfalls wichtig: Die drei Phasen des Drahterodierens müssen zu 100% aufeinander bzw. auf das zu bearbeitende Material abgestimmt sein. Falsche Einstellungen können zu unsauberen Ergebnissen oder Drahtriss führen.

Dual Interface – Kartenmodell für mehr Flexibilität

Wenn von Dual Interface die Rede ist, ist hiermit in der Regel ein bestimmter Typ von Chipkarten gemeint. Eine Dual Interface-Karte stellt die neuste Generation von sicherheitsoptimierten Chipkarten dar, obwohl dieser Typ eigentlich bereits seit mehreren Jahren im Umlauf ist. Dual Interface-Karten kombinieren die Möglichkeit einer kontaktlosen sowie einer kontaktbasierten Datenübertragung mittels eines einzigen Chips. Das macht sie im Gegensatz zu den bekannten Hybridkarten deutlich flexibler. Nachfolgend geben wir einen Überblick über die verschiedenen Varianten von Chipkarten, um die besonderen Vorteile der Dual Interface-Karte herauszustellen.

Kontaktbasiert oder nicht – Dual Interface-Karten als Problemlöser

Herkömmliche Chipkarten sind meist mit einer von zwei möglichen Schnittstellen ausgestattet, über welche Datenübertragungen vorgenommen werden können. Kontaktbasierte Chipkarten benötigen, wie der Name bereits verrät, den unmittelbaren (physischen) Kontakt mit einem entsprechenden Lesegerät. Erst wenn dieser Kontakt hergestellt ist, können die Daten von der Karte übertragen werden. Demgegenüber stehen meist die sogenannten RFID Chipkarten, die eine kontaktlose Datenübertragung möglich machen. Hochfrequente Radiowellen oder magnetische Wechselfelder, die vom abgestimmten Lesegerät ausgehen, dienen dazu die auf dem Chip der RFID Karte gespeicherten Daten abzurufen. Hierfür wird die Energie von der im Chip integrierten Antenne aufgenommen und decodiert. Gleichzeitig dient die Energie in den meisten Fällen der Stromversorgung des Chips auf der Karte. Beide Arten von Karten befinden sich heute im Umlauf und bringen jeweils individuelle Vor- und Nachteile mit sich.

Kombinationsmöglichkeiten von kontaktlosen und kontaktbasierten Datenübertragungsmöglichkeiten haben sich über viele Jahre hinweg vornehmlich auf den sogenannten Hybridkarten wiedergefunden. Diese verfügen zum einen über eine kontaktbasierte Schnittstelle, wie zum Beispiel einen Magnetstreifen, und eine Antenne für die kontaktlose Datenübertragung. Hybridkarten sind dementsprechend dadurch gekennzeichnet, dass sie über zwei voneinander getrennte Schnittstellen Daten übertragen können. Die Dual Interface Technik bildet somit im übertragenen Sinn die nächste Stufe auf der Evolutionsleiter: Sie vereint beide Schnittstellen in nur einem Chip. Dabei verfügt sie über ein Chipmodul, das gleichzeitig eine Kontaktfläche und eine Antenne besitzt, um beide Varianten der Datenübertragung zu ermöglichen.

Vorteile von Dual Interface – Chipkarten der neuen Generation

Dual Interface-Karten werden bereits in vielen verschiedenen Bereichen eingesetzt, denn sie kombinieren die Vorteile früherer Kartengenerationen auf eindrucksvolle Weise. Herkömmliche kontaktbasierte Chipkarten bringen stets das Risiko einer Verschmutzung der Schnittstelle mit sich. Ist diese beschädigt, können die Daten auf der Karte nicht ausgelesen werden. Das wiederum führt für den Karteninhaber zu Komplikationen. Karten mit kontaktloser Datenübertragung sind dagegen vielerorts einsatzbeschränkt, weil die spezifischen Auslesegeräte und -technologien nicht überall vorhanden sind. Während die neusten Standards in vielen Großstädten und Instituten bereits Gang und Gäbe sind, sind es vor allem regionale und lokale Dienstleister und Geschäfte, die mit den kontaktlosen Datenübertragungen noch ihre Schwierigkeiten haben. Dual Interface liefert für beide Probleme eine Lösung: Durch die Kombination aus kontaktbasierter und nicht kontaktbasierter Datenübertragungsmöglichkeit bietet Dual Interface für Chipkarten maximale Flexibilität und Funktionalität in einem. Das erklärt auch die vielseitigen Einsatzgebiete, in denen die Dual Interface-Karten bereits genutzt werden.

Hierzu gehören unter anderem sogenannte elektronische Identifikationskarten, aber auch elektronische Führerscheine sowie Krankenversichertenkarten sind mit der Dual Interface-Technik ausgestattet. Zukünftig werden mit großer Wahrscheinlichkeit weitere Einsatzgebiete erschlossen, denn Markforschungsanalysen haben ergeben, dass die Nachfrage nach Dual Interface-Karten stetig wächst.

Elektrolyseur

Ein Elektrolyseur ist eine technische Anlage, die mithilfe von elektrischem Strom Wasser (H₂O) in seine Bestandteile Wasserstoff (H₂) und Sauerstoff (O₂) aufspaltet – ein Prozess, der als Elektrolyse bezeichnet wird. Diese Schlüsseltechnologie ist essenziell für die Erzeugung von grünem Wasserstoff, sofern der eingesetzte Strom aus erneuerbaren Quellen stammt.

Funktionsweise im Überblick:

Anode (Pluspol): Hier entsteht Sauerstoff. Elektronen werden dem Wassermolekül entzogen.

Kathode (Minuspol): Hier entsteht Wasserstoff. Elektronen werden zugeführt.

Elektrolyt: Leitet die Ionen zwischen Anode und Kathode, ohne dass sich die Gase vermischen.

Stromquelle: Liefert den für die Elektrolyse nötigen Gleichstrom.

Die erzeugten Gase werden anschließend getrennt aus dem System geleitet und können vielfältig genutzt werden – Wasserstoff z. B. als klimaneutraler Energieträger in Industrie, Mobilität oder zur Zwischenspeicherung erneuerbarer Energie.

Relevanz für den smarten Maschinenbau:

In der modernen Fertigung spielt der Elektrolyseur eine zentrale Rolle für nachhaltige Produktionsprozesse und die Transformation hin zu CO₂-armen Industrien. Smarte Maschinenbauunternehmen wie MackSmaTec tragen durch modulare, skalierbare Systeme zur Integration dieser Technologie in industrielle Wertschöpfungsketten bei.

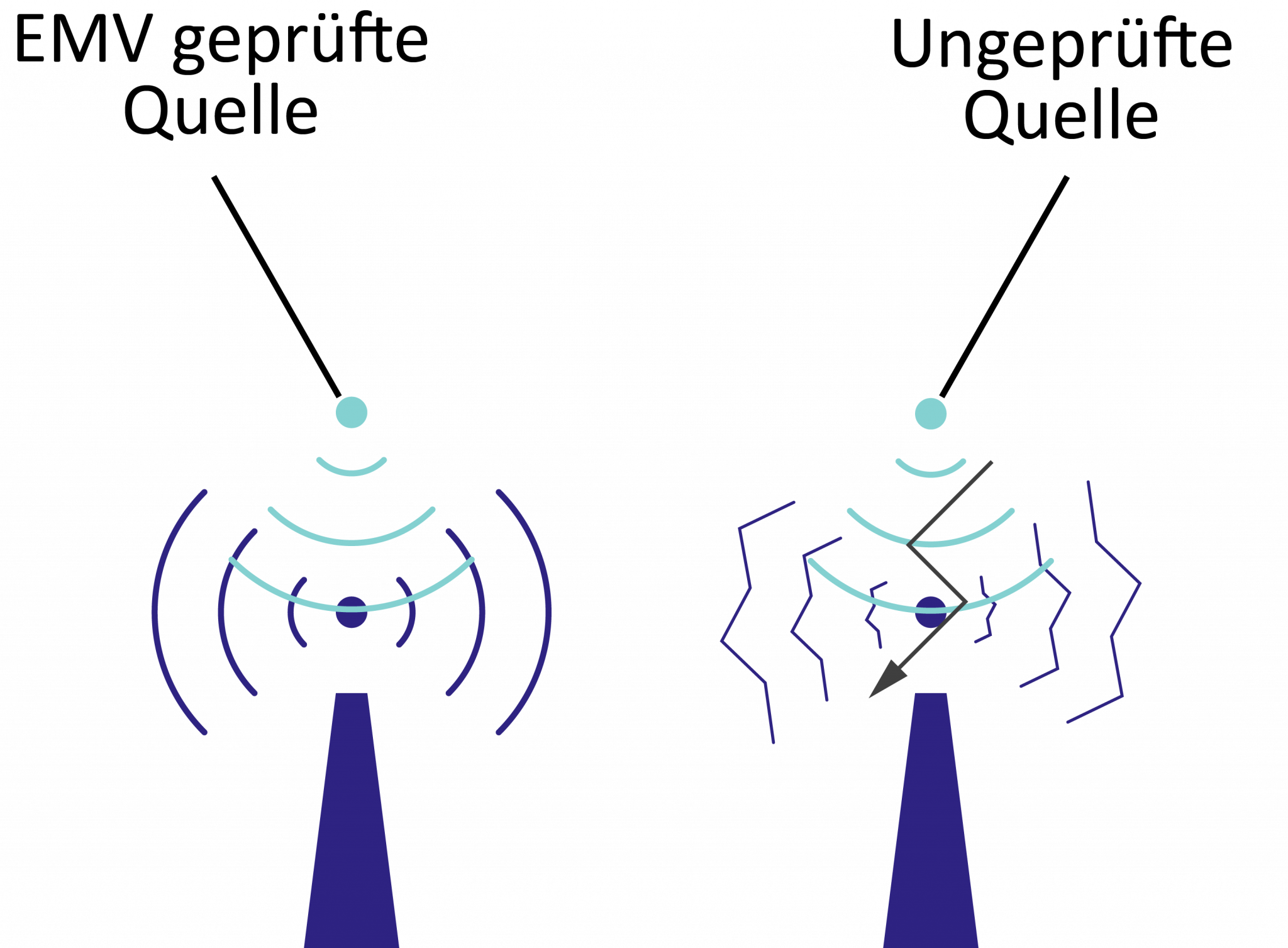

EMV – Elektromagnetische Verträglichkeit

Die Abkürzung EMV steht für Elektromagnetische Verträglichkeit und bezeichnet die Fähigkeit technischer Geräte selbst keine beabsichtigten oder unbeabsichtigten elektrischen oder elektromagnetischen Impulse/Effekte auszusenden, welche wiederum andere technische Geräte beeinflussen bzw. stören könnten. Besonders wichtig: Die EMV muss unabhängig von der Inbetriebnahme des Geräts gewährleistet sein. Dementsprechend darf eine ausgeschaltete Maschine ebenso wenig Störeffekte bei einem anderen Gerät verursachen, wie eine laufende Maschine. Die Elektromagnetische Verträglichkeit ist per Definition zudem ein wechselseitiges Charakteristikum. Das bedeutet, dass die EMV nicht nur das aktive Beeinflussen, sondern überdies das passive Beinflusstwerden ausschließt. Ein technisches Gerät verfügt demnach genau dann über Elektromagnetische Verträglichkeit, wenn es andere Geräte nicht beeinflusst oder sich selbst beeinflussen lässt.

Mithilfe verschiedener Prüfverfahren in punkto EMV sollen gewollte oder ungewollte Beeinflussungen zwischen technischen Geräten verhindert werden. Dies ist notwendig, um die Funktionalität von Maschinen langfristig gewährleisten zu können und Defekte zu verhindern. Darüber hinaus spielt der rechtliche Aspekt eine wesentliche Rolle: Durch die Beeinflussung von technischen Geräten und Einrichtungen können bei fehlender Elektromagnetischer Verträglichkeit große Schäden entstehen. So können elektromagnetische Effekte beispielsweise dafür verantwortlich sein, dass sich im Fernsehgerät der Rauschanteil erhöht oder die Elektronik des Geräts komplett ausfällt. Auch beim Luftverkehr sind elektromagnetische Wellen unter Umständen problematisch, weshalb die Elektromagnetische Verträglichkeit gesichert werden muss. Dies ist auch der Grund, warum in den meisten Flugzeugen kein Mobiltelefon außerhalb des Flugmodus verwendet werden darf. Weitere Beispiele können im industriellen Anlagen- und Maschinenbau gefunden werden, wo in der Regel zahlreiche unterschiedliche technische Geräte mit einer hohen Leistung parallel in Benutzung sind. Um hier effizient und sicher arbeiten zu können, muss die EMV der einzelnen Geräte unbedingt gewährleistet sein.

Gesetzliche Bestimmungen zur EMV

In Deutschland gilt das 2016 neu gefasste Elektromagnetische-Verträglichkeit-Gesetz, welches sich auf Betriebsmittel bezieht, die entweder selbst als Verursacher elektromagnetischer Störungen angesehen oder die durch elektromagnetische Störungen anderer Verursacher beeinflusst werden können. Mit Ausnahme einiger Geräte, beispielsweise von luftfahrt- oder militärtechnischen Anlagen, kommt das Gesetz flächendeckend zur Anwendung. Der Hersteller des jeweiligen Geräts, bzw. derjenige, der das Gerät in den Handel bringt, hat die Erfüllung des Gesetzes zur EMV sicherzustellen. Dies geschieht in der Regel über verschiedene Prüf- und Nachweisverfahren. Diverse Gerätenormen mit jeweils zugeordnetem Thema sind hierfür im Umlauf. So beschäftigt sich beispielsweise die Fachgrundnorm EN 61000-6-4:2007 + A1:2011 mit der Störaussendung für Industriebereiche.

Etikettieren

Das Etikettieren umfasst das Labeln von Produkten und Gegenständen. Diese werden im Zuge des Etikettierens mit einem Etikett versehen, auf dem verschiedene Angaben stehen können. Besonders typisch ist das Etikettieren bei Getränkeflaschen, aber auch vielen anderen Lebensmitteln: Auf dem Etikett werden nicht nur Angaben zu den Zutaten, sondern auch das Mindesthaltbarkeitsdatum, der Strichcode, der Markenname und viele weitere Informationen aufgeführt. In der industriellen Fertigung läuft das Etikettieren normalerweise halb- oder vollautomatisch ab. Doch genauso gut kann das Etikettieren von Hand vorgenommen werden. Mithilfe kleiner Handetikettierer lässt sich dies heute vergleichsweise schnell bewerkstelligen. Die Preisauszeichnung im Supermarkt gilt hierfür als bekanntestes Beispiel.

Wie funktioniert das Etikettieren?

In Abhängigkeit von der ausgewählten Etikettiermaschine läuft das Etikettieren entweder manuell, halb- oder vollautomatisch ab. Beide automatisierten Maschinen arbeiten mit Etiketten, die auf großen Rollen in die Etikettiermaschine eingelegt werden. Je nach zugrundeliegender Technik werden die Etiketten anschließend über eine Rolle oder eine Bürste oder einen ausfahrbaren Stempel aufgebracht. Bei den Etiketten handelt es sich in der Regel um Klebeetiketten, weshalb man hierbei häufig auch von der Selbstklebe-Etikettierung spricht: In der Maschine werden die Etiketten von der Trägerfolie gelöst, indem sie über eine sogenannte Spendekante geschoben werden. Anschließend wird das Etikett auf dem zu etikettierenden Gegenstand aufgebracht.

Welche Verfahren gibt es beim Etikettieren?

Beim Etikettieren kommen verschiedene Techniken zum Einsatz. So gibt es zum Beispiel das Tamp-on-Verfahren, bei dem das Etikett über den Spendearm gewissermaßen auf das zu etikettierende Objekt aufgestempelt wird. Das erlaubt unterschiedlich hohe Produkte zu Etikettieren, weil der ausfahrbare Spendearm sich an die Größe des Objekts anpasst. Dieses Etikettier-Verfahren wird beispielsweise für Kartons genutzt. Sollen vorwiegend gleich große Produkte etikettiert werden, empfiehlt sich das Wipe-on-Verfahren. Etikettiermaschinen, die mit diesem Verfahren arbeiten, besitzen statt eines Spendearms eine Bürste oder eine Rolle. Das Objekt fährt auf einem Transportband unter der Bürste oder Rolle entlang und so wird das Etikett aufgetragen. Diese Variante ist schneller, bietet dafür aber weniger Flexibilität. Sie eignet sich zum Beispiel für Fertigungsreihen mit stets gleichbleibender Serienproduktion in hoher Stückzahl. Eine weitere Methode für das Aufbringen von Etiketten mithilfe einer Etikettiermaschine ist das Blow-on-Verfahren. Dieses empfiehlt sich besonders für druckempfindliche Etiketten, weil es nicht über direkten Druckkontakt, sondern mithilfe von Druckluft funktioniert. Hierbei werden die Etiketten vermittels Druckluft auf dem zu etikettierenden Objekt aufgebracht. Eine Kombinationsvariante ist das Tamp-Blow-Etikettieren, bei dem mit Druckluft und einem Stempel gearbeitet wird. Beide Varianten ermöglichen das Etikettieren bei überzeugenden Geschwindigkeiten.

Wofür wird das Etikettieren genutzt?

Einige Beispiele für mögliche Einsatzgebiete von Etikettiermaschinen wurden bereits benannt: Flaschen, Lebensmittelbehälter oder Pakete. Daneben gibt es aber noch viele weitere Bereiche, in denen etikettiert wird: So werden etwa fehlerhafte Reisepässe bereits bei der Produktion mit Etiketten versehen, damit diese erst gar nicht in Umlauf kommen. Auch im Montagebereich kommen Etikettiermaschinen zum Einsatz: Mithilfe der Etiketten wird die Traceability bzw. Nachvollziehbarkeit des Produktweges sichergestellt. Hier erweist sich das Etikettieren häufig als günstige Alternative zum Lasern. Eine weitere Verwendungsmöglichkeit ist die Nutzung des Etikettierens zum Verbinden zweier Komponenten: Im Klebespender der Etikettiermaschine befindet sich dann doppelseitiges Klebeband, welches genutzt wird, um zwei Werkteile miteinander zu verbinden.

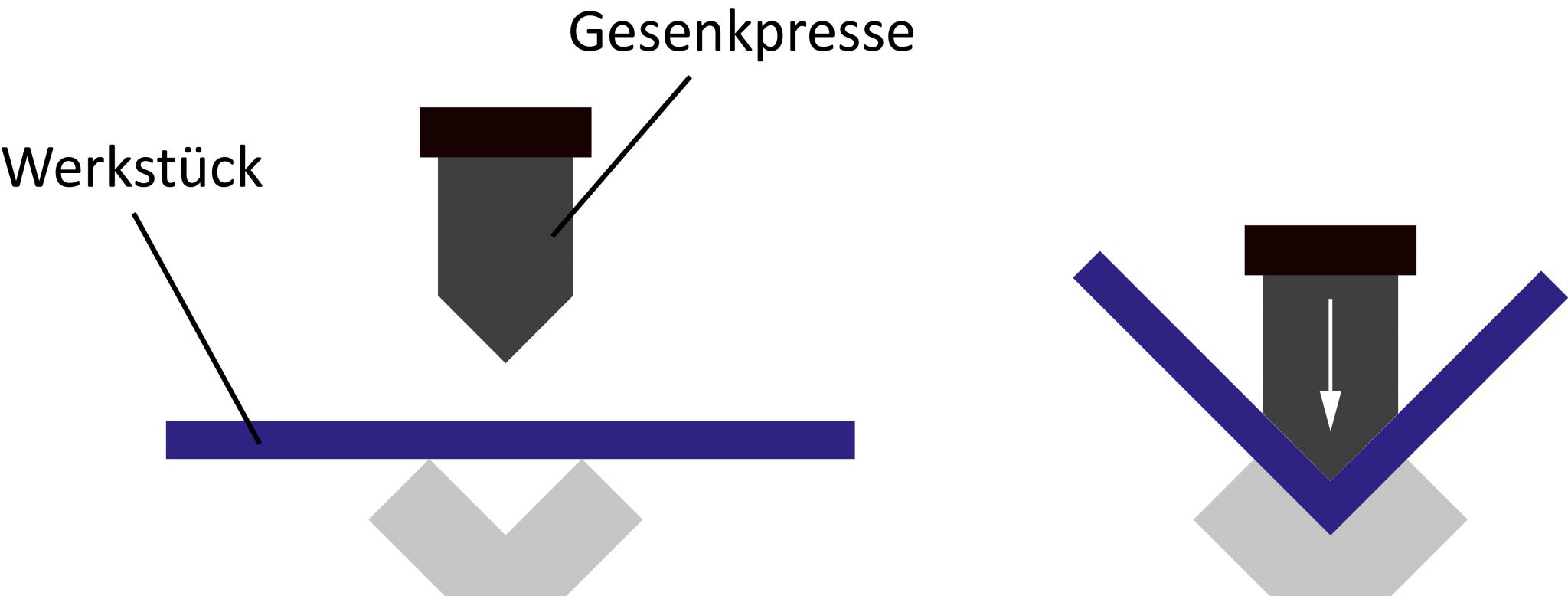

Gesenkbiegepressen – Blechbearbeitung mit hoher Präzision

Eine Gesenkbiegepresse wird häufig auch als Kantbank oder Abkantpresse bezeichnet und ist eine Maschine mit deren Hilfe große und gebogene Bleche mit hoher Präzision gefertigt werden können. Eine mögliche Alternative zur Gesenkbiegepresse ist die Schwenkbiegemaschine, die nach einem ähnlichen Prinzip arbeitet, jedoch vorrangig bei kleineren Losgrößen zum Einsatz kommt.

Wie funktioniert das Gesenkbiegepressen?

Das Gesenkbiegepressen funktioniert nach einem sehr einfachen Prinzip: Die Gesenkbiegepresse besteht aus einem Pressbalken, der von oben nach unten auf ein Gesenk bzw. eine Matrize gesenkt wird. Am Kopf den Pressbalkens wird wiederum ein Stempel befestigt, der auf das Blech, welches sich zwischen Matrize und Pressbalken befindet, gedrückt wird. Hierdurch hebt sich das zu biegende Blech nach oben und es wird ein Biegewinkel erzeugt. Es ist möglich mehrere Biegungen in einem Werkstück herzustellen, allerdings muss das Blech hierfür aus der Maschine genommen und neu positioniert werden. Die Gesenkbiegepresse verbleibt bei der Neuausrichtung unverändert, was den minimalen Zeitaufwand auch für die Fertigung komplexer Biegeprofile

Was sind die Vorteile vom Gesenkbiegepressen?

Zugegeben das Gesenkbiegepressen birgt auch Nachteile, wie zum Beispiel, dass für viele Arbeitsaufträge ein Werkzeugwechsel zu erfolgen hat, der Zeit kostet und damit die Effizienz schmälert. Umso positiver fällt jedoch auf, dass das Gesenkbiegepressen vielseitig eingesetzt werden kann. Mithilfe dieses Verfahrens werden beispielsweise Blechteile bearbeitet, die später unter anderem bei Aufbauten für LKWs, als Verkleidungsteile oder Komponenten großer Maschinen eingesetzt werden können. Gesenkbiegepressen neuester Generationen können außerdem mit einer CNC-Steuerung ausgestattet sein. Dadurch lassen sich noch exaktere Steuerungsmöglichkeiten realisieren und gleichzeitig kostbare Arbeitszeit einsparen. Auch in punkto Sicherheit sind moderne Gesenkbiegepressen an den höchsten Standards ausgerichtet: Lichtschranken und Sicherheitslaser helfen Unfälle zu vermeiden und das Verletzungsrisiko zu verringern.

Glob Top – Verkapselungsmaterial für mikroelektronische Anwendungen

Bei Glob Top handelt es sich um eine flexible und feste Verkapselung, die unter UV-Licht, sichtbarem Licht oder thermisch ausgehärtet freiliegende Bauteile schützt. Aber auch integrierte Schaltkreise oder Drahtverbindungen werden damit gesichert. Hierfür werden spezielle Klebstoffe eingesetzt. Ebenfalls Verwendung finden sie für Chip-on-Board-Anwendungen oder für die Befestigung von Schaltkreisen auf Glas bzw. PCB. Die hierfür verwendeten Vergussmassen aus Kunststoffen gibt es in unterschiedlichen Viskositäten.

Glob Top - Schutz vor äußeren Einflüssen

Die Verkabelungsmaterialien bzw. Vergussmassen schützen im sogenannten Glob Top Verfahren Elektronikkomponenten vor unterschiedlichen äußeren Einflüssen:

Staub

Feuchtigkeit

Lösemittel

Schmutz

Des Weiteren findet Glob Top Anwendung zum Schutz von besonders empfindlichen Bauteilen gegen Verkratzungen oder mechanische Belastung. Außerdem reduzieren sie die Lokalelementbildung und schützen vor innerer Korrosion. Die eingesetzten Vergussmassen sind in der Regel UV-härtend. Je nach verwendetem Material kann die Aushärtung bereits innerhalb von wenigen Sekunden erfolgen. Die Versiegelung der Bauteile oder Komponenten kann vollautomatisiert erfolgen.

Vergussmassen, die thermisch aushärten, haben den Vorteil, dass sie auch dann aushärten, wenn kein Licht vorhanden ist, wie zum Beispiel in dunklen Räumen oder in Schattenzonen. In der Regel erfolgt die Aushärtung von schwarz eingefärbten Glob Tops ausschließlich thermisch. Sie werden als Beschichtung oder Abdeckung eingesetzt. Die Vergussmassen können nach erfolgter Aushärtung kurzfristig bis 280° C belastet werden - dadurch überstehen sie schadlos einen Reflow-Prozess.

Glob Tops speziell für Chips

Auch zum Schutz von Chips werden Glob Tops eingesetzt. Sie verkapseln den Chip und stellen so sicher, dass empfindliche Drahtkontakte nicht abbrechen. Gleichzeitig erfolgt ein Schutz vor Verkratzungen, Feuchtigkeit und Staub. Die Chipkarten werden durch die eingesetzten Vergussmassen gleichzeitig gegen Cory Korrosion geschützt. Da sie lösungsmittelfrei sind und eine hohe Ionenreinheit besitzen, reduzieren sie gleichzeitig die Lokalelementbildung. Damit sind die Chips haltbarer und verlässlicher.

Sehr häufig wird für die Verkapselung von Chips das Frame-and-Fill-Verfahren (Dam-and-Fill) eingesetzt. In diesem Verfahren wird zunächst einmal unter Einsatz von hochviskosem Klebstoff ein Damm gezogen, der als Rahmen dient. Im Anschluss darauf erfolgt eine Auffüllung vom Rahmen mit flüssigem Kunststoff. Durch den Rahmen wird das Zerfließen des Materials verhindert. Stattdessen ummantelt es weich den Chip inklusive der Kontakte.

Vorteile der Flüssigverkapselung im Glob Top Verfahren

Glob Top gehört zu den Verfahren der Flüssigverkapselung. Das Ziel ist, bei Raumtemperatur elektronische Bauteile mit einer flüssigen Substanz zu schützen. Dafür sind keine produktspezifischen Werkzeuge erforderlich. Zum Einsatz kommen wahlweise ein- oder zweikomponentige Vergussmassen. Sie beruhen überwiegend auf Epoxidharz, Silikon, Polyurethanen oder Acrylat und härten thermisch aus. Meistens sind sie bereits vorgemischt. Häufig zum Einsatz kommen auch einkomponentige Polymersysteme. Sie haben den Vorteil, dass sie unter UV-Licht abbinden. Die Wahl des Materials muss so stattfinden, dass die Isolationseigenschaften und die elektronischen Anforderungen berücksichtigt werden.

Das Vergussmaterial muss eine hohe chemische Reinheit aufweisen, um erfolgreich eine Korrosion zu verhindern. Ansonsten können bei kurzen Leiterabständen Fehlströme abfließen. Aus diesem Grund werden sehr häufig Klebstoffe als Vergussmasse eingesetzt, die aus Epoxidharz bestehen und innerhalb kürzester Zeit mithilfe von UV-Strahlung aushärten. Dadurch sind sie für eine vollautomatische und hochvolumige Fertigung geeignet. Die Aushärtung mit UV-Licht oder sichtbarem Licht sorgt für eine besonders schnelle Verarbeitung. In Schattenbereichen ist ein thermisches Nachhärten möglich. Moderne Vergussmassen sind in der Praxis meistens einkomponentig, wodurch kein Anmischen erforderlich ist. Außerdem sind sie frei von Lösungsmittel, härten per LED, sind halogenfrei, besitzen einen geringen Modulus für Drahtbonden, sind frei von Isozyanat und besitzen eine niedrige Glasübergangstemperatur. Die verschiedenen Materialien, die für das Glob Top Verfahren eingesetzt werden, unterscheiden sich auch in ihrer Flexibilität und in ihrer Haftkraft.

-

-

- /

-

-

-

- /

-

GSM – digitales Mobilfunksystem

GSM ist ein Mobilfunk Standard, der erstmalig 1991 in Finnland genutzt wurde. GSM ist die Abkürzung von Global System for Mobile Communication und wird auch mit 2G bezeichnet. Das Mobilfunksystem ist nicht nur in Europa verbreitet, sondern weltweit. Dabei handelt es sich um eine von drei Varianten der drahtlosen Telefontechnologien, zu denen auch TDMA und CDMA zählen. Die GSM Technologie komprimiert und digitalisiert Daten und sendet sie danach mit zwei Datenströmen, die ein eigenes Zeitfenster besitzen, über einen Kanal. Die von GSM genutzten Frequenzbereiche lauten 890 bis 915 MHz, 935 bis 960 MHz, 1.710 bis 1.785 MHz sowie 1.805 bis 1.880 MHz. GSM wird jedoch nicht nur für den Mobilfunk genutzt, sondern auch von anderen Technologien, wie zum Beispiel General Packet Radio System (GPRS), High-Speed Circuit-Switched Data (HSCSD), Long Term Evolution (LTE), Enhanced Data GSM Environment (EDGE), sowie Universal Mobile Telecommunications Service (UMTS).

Was bedeutet Global System for Mobile Communication genau?

GSM ist ein weltweit eingesetzter technischer Funkstandard für die digitale Funktelefonie und ist derjenige, der am weitesten verbreitet ist. Der Standard wird nicht nur für die Übertragung von Telefonie genutzt, sondern auch für Datenübertragungen oder für Übertragungen von Kurzmitteilungen. Das Global System for Mobile Communications hat das analoge Mobilfunknetz abgelöst. 1991 erfolgte ein Probebetrieb und im Sommer 1992 gab es dann die ersten GSM Mobilfunknetze. Sie funkten im Bereich von 900 MHz. Etwas später kam dann noch der Frequenzbereich um 1800 MHz dazu.

GSM wurde in den letzten Jahren laufend weiterentwickelt. Dabei handelt es sich um einen Standardisierungsprozess, der kontinuierlich weiterverfolgt wurde. 2000 erfolgte dann die Übergabe an 3GPP, dem 3rd Generation Partnership Project. Das ist eine Kooperation von mehreren weltweiten Standardisierungsgremien für den Mobilfunk. Sie ist verantwortlich für UMTS, GERAN und LTE. In den kommenden Jahren wird das 2G Mobilfunknetz verkleinert werden, allerdings nicht abgeschaltet, denn nach wie vor sind noch viele Geräte auf GSM angewiesen. Nach und nach werden die frei werdenden Frequenzen dann für UMTS (3G) und LTE (4G) genutzt.

Technische Aufbau vom GSM Netz

Generell werden für ein GSM Netz vier Bauteile benötigt:

Ein Mobiltelefon oder mobiles Endgerät, das über eine Antenne und eine Sende- und Empfangseinheit verfügt. Außerdem gibt es ein Mikrofon und einen Lautsprecher. Die Stromversorgung erfolgt mit einem Akku oder mit dem Stromnetz. Mit diesem Gerät besteht die Möglichkeit, mit anderen Teilnehmern zu kommunizieren, indem diese ausgewählt werden. Die Wahl kann über eine Spracheingabe oder über eine Tastatur erfolgen. Darüber hinaus verfügt das mobile Gerät in der Regel über ein Display. Auf dem Bildschirm werden nicht nur Telefonnummern angezeigt, sondern auch Kurznachrichten. Der wesentliche Bestandteil des mobilen Geräts ist aber die SIM-Karte.

Ein Mobilfunksendesystem oder ein Base Station Subsystem ist das zweite Bauteil, das es beim GSM Netz gibt. Es kann aus einer oder mehreren Stationen bestehen, die jeweils eine Antenne besitzen und damit eine oder mehrere Funkzellen versorgen. Mit der Basisstation ist eine zentrale Steuerungseinheit verbunden, die die Funkverbindungen überwacht. Außerdem leitet sie - falls erforderlich - einen Zellenwechsel ein. An den Steuerungseinheiten ist eine Umwandlungseinheit gekoppelt, die dafür verantwortlich ist, dass die von GSM komprimierten Sprachkanäle, aber auch unkomprimierte ISDN Audio Kanäle, umgewandelt werden in ein komprimiertes Audio Codec.

Der dritte Baustein in einem GSM Netz sind das Network Switching Subsystem bzw. das Core Network Subsystem - die Vermittlungseinheiten. Sie sind die Schnittstelle und Vermittlungsstelle zwischen dem jeweiligen Mobiltelefonnetz und dem Funknetz – dem Mobile-Service Switching Centre. Die Informationen über den Teilnehmer werden innerhalb des Mobilfunknetzes von dem Visitor Location Register gespeichert. Das Home Location Register hingegen speichert lediglich Informationen über Teilnehmer, die zur Kundschaft des jeweiligen Eigentümers des Funknetzes zählen. Die Authentifizierung erfolgt im Authentication Centre und die Speicherung der Seriennummern der für den Kontakt genutzten mobilen Endgeräte wird optional im Equipment Identity Register registriert.

Der vierte und letzte Systembaustein ist das Network Management Center bzw. das Operation and Maintenance Center. Hiermit wird das mobile Funknetz überwacht. Dieser Baustein kontrolliert zudem auch die zentrale Steuerungseinheit des Mobilfunksendesystems, die Basisstation sowie das Mobile-Services Switching Centre. Alle Teilnehmer in einem GSM Netz sind mit unterschiedlichen Nummern versehen und adressiert. Dazu ist eine Mobile Subscriber ISDN Number erforderlich. Mit ihr kann der Teilnehmer weltweit erreicht werden. Der Teilnehmer wird innerhalb des Funknetzes mit der International Mobile Subscriber Identity gefunden. Diese ist übrigens auch auf der SIM-Karte gespeichert. Es erfolgt aus Datenschutzgründen allerdings nur eine einmalige Authentifizierung bei der ersten Nutzung. Danach wird ausschließlich die Temporary Mobile Subscriber Identity verwendet. Zu guter Letzt gibt es die Mobile Station Roaming Nummer. Diese kommt dann zum Einsatz, wenn außerhalb des Routings des Mobilfunknetzes telefoniert wird - das sogenannte Roaming.

Der Einsatz von GSM außerhalb der Telefonie

Außerhalb von Telefongesprächen wird GSM auch für die Datenübertragung genutzt. Allerdings liegt die Datenübertragungsrate bei lediglich 14,4 kbit/s und entspricht daher nicht dem üblichen Standard. Das ist auch der Grund, warum Smartphones und Tablet PCs inzwischen andere Mobilfunknetze nutzen. Denn modernere Technologien schaffen eine deutlich schnellere Übertragung. Ursprünglich wurde GSM ausschließlich für die Sprachübertragung entwickelt und ausgelegt, aus dem Grund ist das GSM Mobilfunknetz auch nur bedingt für eine Datenübertragung nutzbar.

Es gibt inzwischen verschiedene Verfahren, die die Datenübertragung verbessern und beschleunigen. Dazu gehört beispielsweise auch das Verbindungsprotokoll X.75. Es sorgt für einen schnelleren Verbindungsaufbau, allerdings sorgt es nicht für eine tatsächliche Verbesserung der Schnelligkeit der Datenübertragung. Aus dem Grund wurde GSM weiterentwickelt mit GPRS und EDGE. Dadurch erfolgt eine Datenübertragung im Paket und es werden Geschwindigkeiten bei GPRS von 56 erreicht und bei EDGE von 150 bis 200 kbit/s.

Weiterführende Informationen:

https://de.wikipedia.org/wiki/Global_System_for_Mobile_Communications

https://www.elektronik-kompendium.de/sites/kom/0910181.htm

Komplizierte Linienmuster für mehr Sicherheit

Bei einer Guilloche handelt es sich kurz gesagt um ein spezielles Linienmuster: Mehrere Linienzüge überlappen einander, verlaufen parallel, kreuzen sich und erzeugen so ein hochkomplexes Muster. Von außen betrachtet, besitzen Guillochen häufig eine ansprechende Ornamentoptik, weshalb sie gern auch in der Kunst eingesetzt werden. Im Zusammenhang mit Wertpapieren und der Chipkartensicherheit sind sie hingegen ein relevantes Sicherheitsmerkmal, das weitestgehend als fälschungssicher eingestuft wird.

Geschichte und Entstehung von Guillochen

Die Entstehung sowie die Geschichte der Guillochen sind aus heutiger Sicht nicht mehr eindeutig zu klären. Vier mögliche Theorien zur Entwicklung der Guillochen sowie deren Namensgebung existieren. Die am häufigsten auftauchende Theorie besagt, dass die Guillochen nach ihrem Erfinder, dem Franzosen Guillot, benannt wurden. Unabhängig von der Entstehungsgeschichte steht eines jedoch fest: Die Guillochen wurden schon vor vielen Jahren als fälschungssicheres Merkmal auf verschiedenen Dokumenten verwendet. Insbesondere Banknoten, Wertpapiere sowie auch Ausweispapiere, Zertifikate und Reisepässe wurden mit den aufwendigen Linienmustern, die häufig die Form von asymmetrisch geschlossenen Ellipsen oder unterschiedlich geformten Kreisbahnen annehmen, bedruckt. In früheren Zeiten wurde hierfür noch eine sogenannte Guillochiermaschine verwendet, bei der die Muster mithilfe von gravierten Druckplatten erzeugt wurden. Schon allein deshalb war es schwer die komplexen Linienornamente ohne weiteres zu fälschen.

Verwendung und Erstellung von Guillochen heute

Guillochen werden auch heute noch als sicherheitsrelevantes Element auf Chipkarten oder Dokumenten verwendet. Je nach Einsatzgebiet werden die Guillochen jedoch nicht mehr mithilfe gravierter Druckplatten hergestellt, sondern unter Berücksichtigung spezifischer Datenbanken und Softwareprogramme am Computer berechnet. Diese Programme bedienen sich verschiedener Linienmustern, um eine Guilloche herzustellen. Unterschieden werden kann hierbei zwischen parallelen Linien, die als Fadenguilloche bezeichnet werden, der Wellenguilloche sowie der Ornamentguilloche. Alle drei Elemente werden miteinander kombiniert. Teilweise existieren heute spezifische Richtlinien, was die Fertigung von Guillochen angeht. So stellt beispielsweise die deutsche Wertpapierbörse in ihren Druckrichtlinien von 1991 vor, dass Guillochen entweder als Positivguillochen oder als Negativguillochen konzipiert werden sollten. Bei den Positivguillochen werden farbige Linien auf eine unbedruckte Fläche aufgebracht, während bei den Negativguillochen die Fläche bedruckt ist und die Linien unbedruckt durch diese Flächen laufen. Darüber hinaus wird zwischen einfarbigen und mehrfarbigen Guillochen unterschieden.

Damit Guillochen als fälschungssicher eingestuft werden können, ist es wichtig, dass die einzelnen Guillochen, sprich Linienmuster, zueinander passen. Die perfekte Genauigkeit, mit der die einzelnen Linien einander überkreuzen, ist schließlich das, was die Guillochen als Sicherheitsmerkmal so attraktiv werden lässt: Diese Genauigkeit lässt sich normalerweise nicht reproduzieren, denn spätestens an den Überschneidungspunkten werden die Linien oft ausgefranst, verdickt oder verschwommen. Darüber hinaus werden zwei- oder mehrfarbige Guillochen häufig durch eine Kombination aus Grund- und Störfarben entwickelt, die es sogar modernsten Auslesegeräten erschwert eine 100%ig genaue Reproduktion herzustellen. Dies wird nicht zuletzt auch dadurch verhindert, dass Guillochen weder einen End- noch einen Anfangspunkt identifizieren lassen. Eine exakte Nachberechnung ist deshalb auch für moderne Softwareprogramme nicht unkompliziert. Ein klassisches Merkmal, anhand dessen sich manipulierte Chipkarten erkennen lassen, sind durchbrochene Guillochen oder Guillochen mit verschwommenen, ausgefransten oder ungleichmäßig verdickten Linien. Auch wenn die Grundmuster der Guillochen asymmetrisch sind, präsentieren sie sich schließlich als vollkommen regelmäßig, weshalb Auffälligkeiten im Zuge von Fälschungen direkt ins Auge springen. Nichtsdestotrotz werden Guillochen beispielsweise auf Chipkarten heutzutage mit anderen Sicherheitsmerkmalen kombiniert, um so einen verstärkten Schutz gewährleisten zu können.

Hairpin-Technologie

Die Hairpin-Technologie ist eine Wickeltechnologie, die unter anderem bei elektrischen Motoren Verwendung findet. Namensgebend für die Technologie sind die Steckspulen, die mit ihrer eckigen U-Form an Haarnadeln – englisch Hairpins – erinnern. Gegenüber der herkömmlichen Spulenwickeltechnik bietet die Hairpin-Technologie entscheidende Vorteile, die sie vor allem für den Einsatz bei Traktionsmotoren in Elektrofahrzeugen attraktiv machen.

Was ist die Hairpin-Technologie?

Die Hairpin-Technologie ist insbesondere in der Automobilindustrie seit einigen Jahren auf dem Vormarsch. Immerhin stellt sie eine zeit- und kostensparende Möglichkeit zur Fertigung von leistungsstarken Elektromotoren dar. Genauer gesagt kommt die Wickeltechnologie beim Stator des Traktionsmotors zum Einsatz. Dieser enthält typischerweise Spulen aus elektrischen Leitern (Kupferdraht), die bis vor kurzem noch aufwendig gewickelt werden mussten. Je nach Dicke des Kupferdrahtes ein arbeitsintensives Verfahren, das viel Zeit in Anspruch nimmt. Dank der Hairpin-Technologie können die kupfernen elektrischen Leiter nun jedoch gesteckt werden: Je nach Fertigungstechnologie werden sie beispielsweise mit einer Druckluftpistole in den Stator eingebracht. Danach müssen die Hairpins nur noch miteinander verdreht und geschweißt werden.

Was sind die Vorteile der Hairpin-Technologie?

Die Hairpin-Technologie bietet bei der Fertigung von Statoren für Elektromotoren gegenüber der gewohnten Spulenwicklung gleich mehrere Vorteile: Durch das beschleunigte Einbringen der Steckspulen in den Stator, verkürzt sich die Fertigungsdauer von Elektromotoren enorm, was wiederum ein zusätzliches Plus auf der Kostenseite beschert. Darüber hinaus können mehr Steckspulen auf engerem Raum gesetzt und miteinander verbunden werden. So erhöht sich der Kupferfüllgrad im Stator, wodurch eine hohe Dauerleistung generiert wird.

Welche Herausforderungen bietet die Hairpin-Technologie?

Die Hairpin-Technologie erweist sich zur Fertigung von Statoren für Elektromotoren in vielerlei Hinsicht als vorteilhaft, geht allerdings auch mit so machen Herausforderungen einher. Allein das Verbiegen (Twisten) und Verschweißen der Hairpins macht den Produktionsprozess kompliziert und fordert innovative Lösungen. Schließlich muss eine Vielzahl an Schweißpunkten in erstklassiger Qualität gefertigt werden. Zudem können die größeren Wickelköpfe der Hairpin-Technologie elektrische Verluste verursachen.

Hologramm – Dreidimensionales Abbild für mehr Sicherheit

Ein Hologramm ist das Ergebnis holografischer Verfahren und Techniken, mit deren Hilfe ein dreidimensionales Abbild oder dreidimensionale Grafiken erstellt werden können. Der Grad der Dreidimensionalität des Abbildes oder der Grafik ist abhängig vom jeweiligen Blickwinkel. Hologramme werden in Kleinstformaten beispielsweise auf Chipkarten eingesetzt, weil sie als fälschungssicher gelten und dank moderner Computertechnologie kostengünstig herzustellen sind.

Das Grundprinzip holografischer Techniken

Holografische Techniken wurden ursprünglich entwickelt, um die Arbeit mit Elektronenmikroskopen zu verbessern. Im Laufe der Zeit erfolgte schließlich eine sukzessive Weiterentwicklung. Das Prinzip holografischer Techniken lässt sich mit Blick auf unterschiedliche Arten von Fotografien erklären: Um eine Schwarzweißfotografie herstellen zu können, ist es wichtig die Intensität des einfallenden Lichtes auf dem Film zu speichern. Bei Farbfotografien werden hingegen zusätzlich zur Intensität auch die Lichtfrequenzen auf dem Film festgehalten. Um nun wiederum ein Hologramm zu erzeugen, muss neben der Intensität (bei farbigen Hologrammen kommt die Lichtfrequenz hinzu) außerdem die sogenannte Phase in Form der Interferenz gespeichert werden. Zur Erklärung: Wenn kohärentes Licht auf ein Objekt trifft, wird dieses Licht vom Objekt reflektiert und gestreut. Die Brechung und Streuung sorgt für die Entstehung eines Wellenfeldes, welches in diesem Fall auch als Objektwelle bezeichnet werden kann. Diese Objektwelle trifft wiederum auf die sogenannte Referenzwelle. Hierbei handelt es sich um das von der Lichtquelle ausgesandte Licht, welches noch ungestreut und ungebrochen ist. Auf diese Weise entstehen zwischen den beiden aufeinandertreffenden Lichtwellen Interferenzmuster, die auf dem Film gespeichert werden. Kurz gesagt: Bei der Erstellung des Hologramms entsteht der dreidimensionale Effekt dadurch, dass die (dreidimensionale) Form des Objekts anhand der Lichtbrechung erkannt und auf das Trägermedium übertragen wird.

Mithilfe dieser holografischen Techniken eine dreidimensionale Aufnahme von einem Objekt zu erstellen, ist relativ aufwendig, weil das Objekt nicht nur über mehrere Minuten komplett unbewegt sein muss, sondern außerdem die Quelle des kohärenten Lichts (Laser) absolut schwingungsfrei aufgestellt zu sein hat. Andernfalls werden die Ergebnisse ungenau und das entstehende Hologramm ist nicht zu gebrauchen. Entsprechend häufig werden heutzutage computergenerierte Hologramme genutzt. Sie bieten einerseits den Vorteil, dass sie deutlich exakter sind und überdies unabhängig vom Objekt berechnet werden können. Diese Form der Hologramm-Erzeugung kommt vor allem bei grafischen Abbildungen zum Einsatz, deren Form sich mathematisch exakt beschreiben lässt. Auch die digitale Holografie bietet schnellere und präzisere Möglichkeiten für die Erstellung von Hologrammen, weil die Rekonstruktion der Abbilder digital erfolgt.

Hologramme als Sicherheitsmerkmal

Hologramme kommen nicht nur in der Kunst oder in der Wissenschaft zum Einsatz, sondern haben ihren Platz als Sicherheitsmerkmal auch im alltäglichen Leben. Viele Chipkarten sind heute mit Hologrammen ausgestattet, weil diese sich als besonders fälschungssicher erweisen. Hergestellt wird das Hologramm auf einer Chipkarte mit einer Kombination aus Lasertechnik und Mehrschichtfolien. Das Hologramm wird entsprechend nicht einfach auf die Karte gedruckt. Der Vorteil: Hologramme können nicht nur schwer ausgelesen werden, sondern sind überdies sehr langlebig, preiswert in der Herstellung und können frei wählbar auf der Kartenoberfläche platziert werden.

In der Praxis werden echte Hologramme häufig mit alternativen Sicherheitsmerkmalen verwechselt: Kinegramme beispielsweise stellen keine dreidimensionalen Abbilder dar, sondern bilden einen zweidimensionalen Bewegungsablauf ab. Ebenfalls etwas gänzlich anderes ist das sogenannte Lenticular. Hierbei handelt es sich um ein Wackelbild, das lediglich für eindrucksvolle Effekte genutzt wird, selbst allerdings keine sicherheitsrelevanten Charakteristika mit sich bringt: Lenticulare oder auch Linsenraster-Bilder können unkompliziert kopiert und nachgedruckt werden.

Druck ohne Berührung

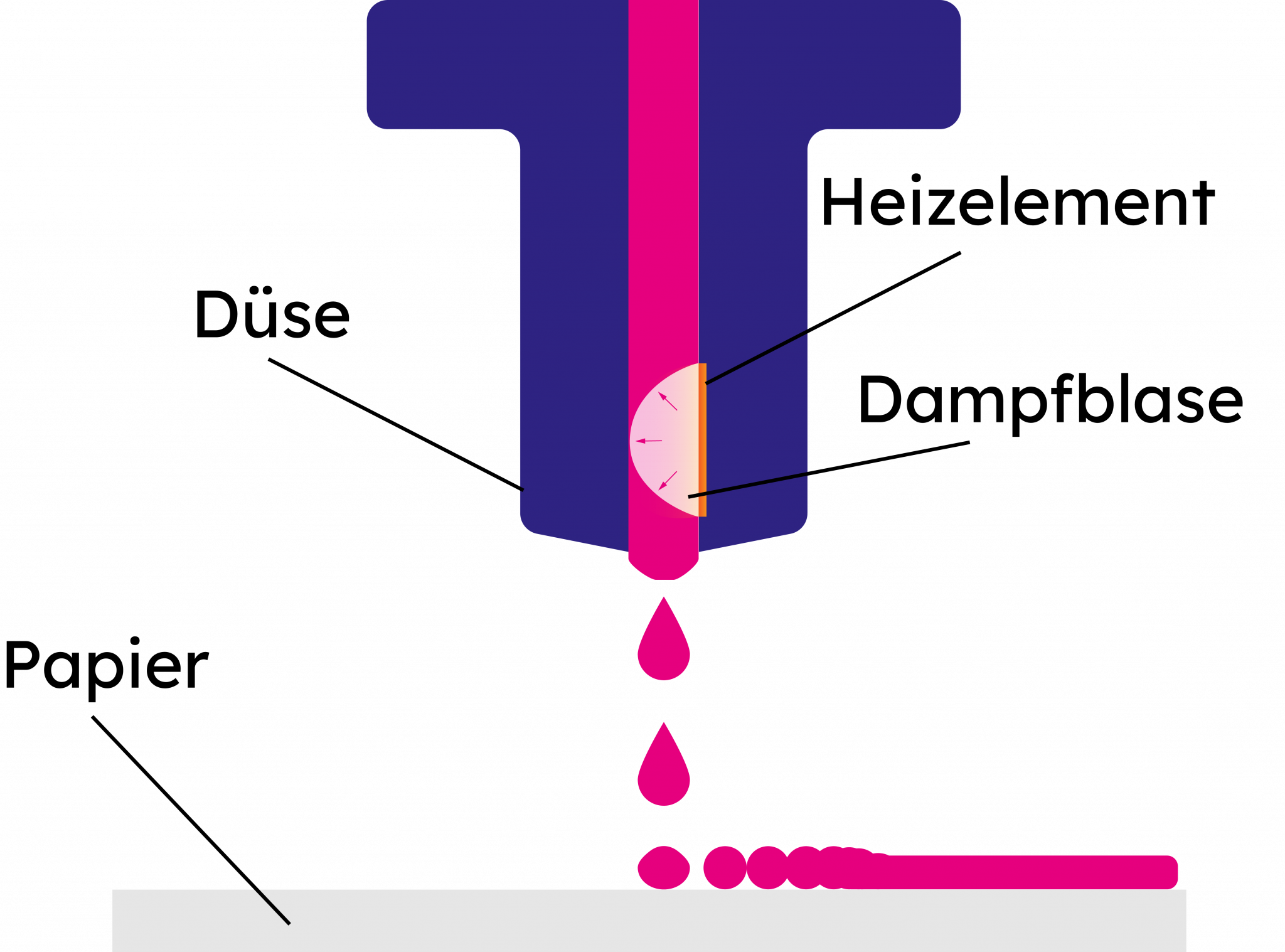

Inkjet ist ein modernes Druckverfahren, das komplett ohne Berührung oder Kontakt zwischen einer Druckvorlage und dem zu bedruckenden Objekt auskommt. Damit steht das Inkjet-Verfahren unter anderem im Gegensatz zum Thermotransfer, bei dem zwischen der speziellen Farbfolie, dem Thermodruckkopf und dem zu bedruckenden Objekt ein Kontakt hergestellt werden muss. Das Inkjet-Verfahren ist Teil digitaler Drucksysteme. Das bedeutet, dass die Übermittlung der Druckvorlage an die Druckeinheit via Computer verläuft. Dadurch sind schnelle und unkomplizierte Umstellungen sowie viele unterschiedliche Druckabläufe hintereinander möglich. Das zweite charakteristische Merkmal für den Inkjet-Druck ist die Arbeit mit Tinten: Diese werden aus einer Düse auf das zu bedruckende Material gespritzt, wobei zwei unterschiedliche Methoden zum Einsatz kommen.

Continuous-Inkjet -Verfahren für besonders schnelle Ergebnisse

Das Continuous-Inkjet-Verfahren kommt vornehmlich im industriellen Bereich zum Einsatz und wird vor allem dann genutzt, wenn Druckergebnisse in einem kontinuierlichen Fluss mit hoher Geschwindigkeit erzeugt werden sollen. Das Vorgehen bei diesem Inkjet-Verfahren ist schnell erklärt: Aus den Düsen des Inkjet-Druckers werden kontinuierlich Tintentropfen gespritzt. So entsteht eine Art Tintenvorhang, wobei jeder einzelne der darin befindlichen Tropfen elektrostatisch aufgeladen ist. Mithilfe von Hochspannungselektroden, die sich vor dem Tintenvorhang befinden, wird parallel dazu ein elektrisches Feld erzeugt. Dieses elektrische Feld ermöglicht es die elektrostatisch aufgeladenen Tintentropfen kontrolliert abzulenken, sodass sie anschließend gezielt und gemäß den Druckvorgaben auf das Trägermaterial treffen.

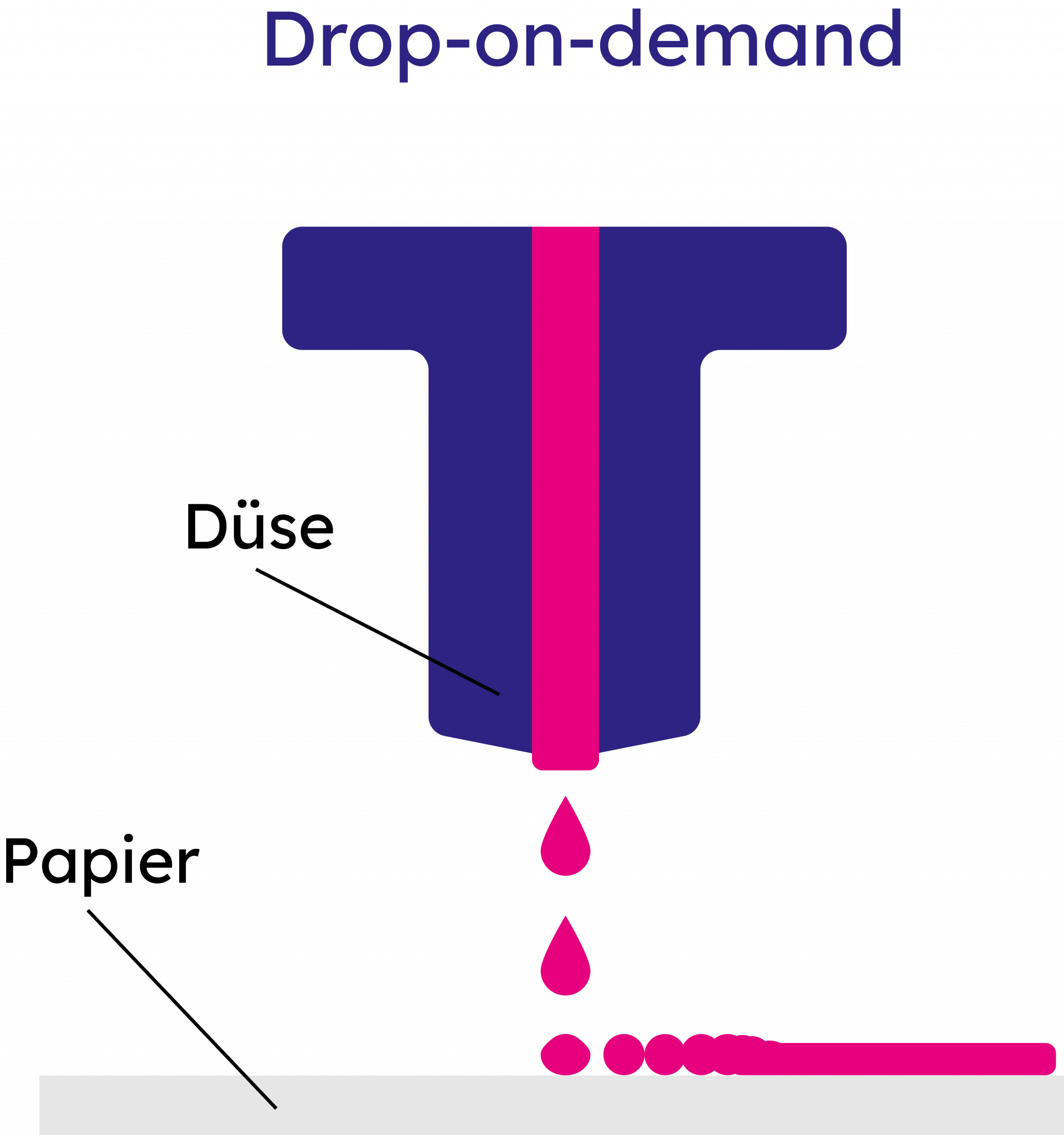

Drop-on-demand-Inkjet-Verfahren für besonders hohe Auflösungen

Im Gegensatz zum Continuous-Injekt-Verfahren steht beim Drop-on-demand-Inkjet-Druck in erster Linie nicht Schnelligkeit im Fokus, sondern Präzision. Anstelle eines ganzen Vorhangs aus Tinte wird immer nur dann ein Tropfen Tinte aus dem Druckkopf gespritzt, wenn er nach den Vorgaben der Druckvorlage auch tatsächlich benötigt wird. Mit diesem Verfahren sind Auflösungen von 600 dpi unproblematisch zu erreichen. Deshalb kommt dieses Inkjet-Verfahren nicht nur in der Industrie, sondern auch in Privathaushalten bei klassischen Tintenstrahldruckern zum Einsatz. Der Unterschied zwischen industriellen Inkjet-Druckern und gewöhnlichen Haushaltsdruckern, die dieses Verfahren nutzen, ist allerdings klar: Während industrielle Geräte mehrere tausend Düsen beinhalten, um maximale Durchsätze zu erzielen, sind beim Heimdrucker nur wenige Düsen vorhanden, die mehrfach über das Trägermaterial bewegt werden müssen.

Wo liegen die Vorteile beim Inkjet-Druck?

Einige Vorteile, die der Inkjet-Druck gegenüber anderen Verfahren mit sich bringt, wurden bereits erwähnt. Insbesondere das kontaktfreie Bedrucken ist eine der großen Stärken dieses Verfahrens. Dadurch wird es möglich selbst unebene oder druckempfindliche Objekte unkompliziert zu bedrucken. Weiterhin sticht die Schnelligkeit bzw. die Flexibilität beim Inkjet-Verfahren positiv hervor. Da kein Umrüsten erforderlich ist und keine feste Druckform oder Schablone benutzt werden muss, lassen sich deutlich schnellere und vielseitigere Druckergebnisse erzielen. Im Gegensatz zum Thermotransfer bietet dies auch mit Blick auf den Datenschutz Vorteile, da keine theoretisch auslesbaren Schablonen oder Druckformen zurückbleiben. Zu guter Letzt fallen die Druckkosten beim Inkjet-Verfahren vergleichsweise gering aus.

Kunststoffschweißen – Fügeverfahren für Kunststoffe

Das Kunststoffschweißen ist ein sogenanntes Fügeverfahren, bei dem zwei Bauteile aus Kunststoff dauerhaft miteinander verbunden werden. Beim Kunststoffschweißen handelt es sich um eine Alternative zu anderen Fügeverfahren wie etwa dem Kleben oder dem Löten. Eingesetzt wird das Kunststoffschweißen vor allem bei Kunststoffen, die sich nicht oder nur unzureichend miteinander verkleben lassen. Das betrifft zum Beispiel Polypropylen (PP), Polyvinylchlorid (PVC) oder Polyethylen (PE). Wichtig für die Verbindung mithilfe vom Kunststoffschweißen ist, dass die Kunststoffe über thermoplastische Eigenschaften verfügen. Das bedeutet, dass sie (wiederholt) schmelzbar sind und sich anschließend wieder verfestigen. Für das Kunststoffschweißen werden je nach Material und Zielvorgabe unterschiedliche Verfahren berücksichtigt. Zudem müssen abhängig vom zu verschweißenden Kunststoff gewisse Umgebungstemperaturen eingehalten werden.

Die verschiedenen Arten des Kunststoffschweißens